|

|

رپورتاژ آگهی,فروش بک لینک,فروش فالوور,فروش ممبر

|

|

|

|

|

|

|

5اشتباه در سئو وردپرس

5اشتباه در سئو وردپرس

بهنامخدا و عرض ادب خدمت دوستان عزیز. سر دیگری به مقوله سئو وردپرس زدیم در منابع wordtracker تا با یکی دیگر از تازههای سئو در خدمت دوستان باشیم. بیشک هرچه از سئو گفته میشود، این مبحث تمامی نداشته و برعکس، هر روز بیشتر از روزهای پیش، گستردگی و اهمیت و پیچیدگی و تئوریهای آن نمایانتر میشود. یکی از افرادی که مدت مدیدیست در این زمینه فعالیت دارد، Tom Ewer، مدیر مجموعه ManageWP است که از توسعه دهندگان پرکار وردپرس نیز به شمار میرود. آنچه در ادامه میخوانید، ترجمه مقاله ایست با عنوان 5crazy SEO mistakes not to make in WordPress (پنج اشتباه دیوانهوار و غیر قابل جبران در سئو وردپرس) نوشته Tom Ewer. (یکی از مواردی که توسط نویسنده اصلی نوشته شده، به علتی که در انتها گفته خواهد شد، در این مقاله ترجمه نشده است) نگارنده با رعایت اصل امانت داری در ترجمه، اقدام به تالیف در بخشهایی که نیازمند توضیحات بیشتر جهت درک بهتر موضوع برای مخاطب پارسی زبان بود را نموده است.

یک دیدگاه بسیار بد و غیرمنطقی، پیرامون وردپرس وجود دارد که گمان میکند هسته وردپرس، خارج از باکسهای کمکی (مانند افزونهها. مترجم) به زیبایی و با نهایت قدرت برای موتورهای جستجوگر سئو شده است و این در حالی است که هسته وردپرس بسیار کند بوده و نیازمند دخالت انسانی برای بهبود است. در واقع اگر فعالیتهای سئو متوقف شود، احتمال بروز ضعف بالقوه در مطالب منتشر شده بسیار بالا میرود. اما حتی بسیاری از افرادی که گمان میکنند وبسایت خود را مهندسی کرده و تمام جوانب را رعایت کردهاند، ممکن است چه در حال و چه در گذشته مرتکب اشتباهات دیوانهوار در سئو شده باشند (همانطور که من مرتکب شدهام). بنابراین، چند لحظهای را بر روی این اشتباهات و تشریح و شناخت آنان متمرکز خواهیم شد.

1 – ارائه نشدن نقشه XML برای سایت: نقشه سایت خود را معرفی کنید، در غیر این صورت ممکن است مطالب شما کشف و دیده نشود. (بنمایه: اساسنامه گوگل) (خوانندگان محترم عنایت داشته باشند که منظور از نقشه سایت، وجود آن در سایت نیست بلکه ارائه دادن آن به وبمستر تولزهایی مانند بینگ و گوگل و یاندکس است. مترجم). من یک قانون سرانگشتی برای این موضوع دارم که استراتژیهای تازه جستجوگرها را به من گوشزد میکند: اگر گوگل میگوید که ارائه ندادن نقشه، ممکن است باعث دیده نشدن مطالب من شود، من این مورد را جدی گرفته و نقشه را حداقل به یکی از موتورهای جستجوگر معرفی خواهم کرد.

اما موضوع نقشههای سایت به همینجا ختم نمیشود و صرفا کاربرد آن، دیده شدن مطلب نیست. نقشه میتواند معرف بخشهایی از وبسایت وبمستر باشد که هیچ استراتژی دیگری قادر به معرفی آنها نیست، اینها اطلاعات اضافهای هستند که تنها در نقشه موجود است (مانند سوار شدن سریع مطالب جدید بر روی آن) یا دادههای متا مربوط به رسانهای خاص (مانند زمان اجرای یک ویدئو) و یا اگر فرد، در حال اجرای یک وبسایت جدید و ارتباط آن با وبسایت دیگر باشید، نقشهها قادرند این تحرکات را نیز به جستجوگرها برسانند که گوگل و سایر جستجوگرها نیز بتوانند ارتباط آن وبسایت و یا لینک را کشف و بررسی نمایند.

بنابراین میتوان گفت که فیزیک و بدنه یک وبسایت برای چشم عنکبوتها، نقشه سایت آنهاست که این چشمها دوست دارند که لباس مناسب را به تن این فیزیک ببینند که همان فرمت مورد پسند آنها، XML است که رباتها با آن، نمایه و سیمای یک وبسایت را میشناسند. فرد میتواند این نقشه را دستی تولید نماید و یا به صورت خودکار آن را بسازد. پیشنهاد من، در ادامه آمده است:

گوگل Sitemaps XML: با بیش از ده میلیون دانلود و درجهبندی متوسط 4.7 از 5، شما میتوانید مطمئن باشید که این افزونه رایگان میتواند کارهای زیاد و موثری برای شما انجام دهد. نقشه وردپرس طراحی شده توسط Yoast: این پلاگین رایگان دارای تعداد زیادی از توابع SEO و باب پسند رباتها است، که یکی از آنها ژنراتور XML نقشه سایت است بسیار عالی و به صورت خودکار، بعد از هر ارسالی به روز میشود. اینها به صورت خودکار به روز میشوند. شما تنظیمات را انجام داده و در دیگر کارهای آنان دخالت نکنید و مابقی کار را به آنها بسپارید. گوگل برای ارائه ندادن نقشه، کسی را جریمه نمیکند. تنها توصیه میکند که چرا شما نقشه سایت خود را ثبت نمیکنید؟

2 – دستهبندی و تگهای ضعیف: من میتوانم چندین ایراد منطقی را به وبسایتهایی که از تگ استفاده نمیکنند یا بد استفاده میکنند (در بعضی موارد به آن به صورت جمعی، رده بندی نیز گفته میشود) وارد کنم. این مساله کاملا منطقی است که برچسپها، مسیرهای تعامل بیشتر را فراهم میکنند اما صحبت ما بر سر نقاط قوت نیست، زیرا همین نقطه قوت، در صورتی که استفاده نشود یا بد و بیربط و بیش از حد استفاده شود، میتواند بازدید کننده را به سرعت قانع کند که وبسایت را ترک کند.

طبقه بندی مطالب با استفاده از برچسبها و تگهای مناسب و مرتبط، نه تنها به کاربران بازدید کننده، بلکه به جستجوگرها نیز کمک میکند که راحت تر مطالب را پیدا نمایند (مانند صفحات بایگانی که رابط آن با جستجوگرها، تگها هستند) که این نیز در نوع خود از مولفههای سئو است. هر چند که بعضی از جستجوگرها ممکن است بایگانی را توسط تگها را SERPs شناخته و نشناسند (هر چند که به ندرت رخ میدهد، که البته گوگل از آن دسته نیست. مترجم) و در عوض، از تگها برای شناسایی بهتر کلمات کلیدی بهره ببرد که وبسایت شما و مطلب مورد نظر با آن هماهنگ شده است.

اجازه دهید موضوع را با یک نمونه بیان کنم. اگر یک وبسایت در زمینه حیوانات و باغ وحش کار میکند و تمرکز ویژهای بر روی کلمه llamas دارد، اگر فرد از صفحات مختلف، تگهایی با عنوان llamas را به صفحات گوناگون بدهد، به خوبی بین صفحاتی با کلمه کلیدی هدف، ایجاد رابطه کرده است که شاخصی بسیار قوی برای گوگل محسوب میشود که ارزش ویژهای برای کلمه llamas قائل شود.

3 – تعریف نشدن آدرسهای متعارف برای سایت: اگر شما تا کنون درباره canonicalization چیزی نشنیدهاید، خود را کنترل کنید، ممکن است موضوع کمی گیجکننده باشد. من برای گفتن این موضوع، به گفتهای از مت کاتز اشاره میکنم : Canonicalization روند چیدن بهترین آدرس در زمانی است که چندین انتخاب وجود دارد و معمولا به صفحات اصلی یا خانگی اشاره دارد. به عنوان نمونه، این مورد را در نظر بگیرید که اکثر مردم از آن استفاده میکنند: www.example.com example.com www.example.com/index.html example.com/home.asp

اما از لحاظ فنی همه این آدرسها با یکدیگر متفاوت هستند. وب سرور میتواند محتوای کاملا متفاوت برای همه آنها را داشته باشد. هنگامی canonicalizes در وبسایت به درستی اجرا شده است، گوگل نیز استقبال کرده و بهترین آدرس را در جایگاههای بهتری قرار میدهد و ما نیز باید سعی کنیم که بهترین آدرسها را در پیوندها انتخاب نماییم. در موردی ساده، شما به گوگل کمک میکنید که جستجو نکند بلکه در بازبینی اول، آدرس متعارف را بردارد و از همه مهمتر اینکه تمامی آدرسها به صورت متعارف و قابل فهم برای گوگل تولید شوند. این کار اساسا یک فرایند سه مرحلهای است:

وردپرس بگوید که آدرسها چگونه باشد (i.e. http://www.yoursite.com/ or http://yoursite.com/)

گوگل (با استفاده از پیام به شما در گوگل وبمستر تولز) بگوید که آدرسها چگونه باشد

استفاده از یک افزونه (مانند افزونه سئو وردپرس طراحی شده توسط Yoast) که این مقوله را تنظیم کرده و اطمینان حاصل شود که URLهای متعارف در هر صفحه از سایت شما تعریف شده است. این موضوع ممکن است کمی پیچیده باشد. شما میتوانید یک راهنمای کامل برای canonicalization در وردپرس را اینجا پیدا کنید.

4 – بهینه نشدن سایت در Google+ Authorship: همانطور که از اوت 2014 و در آخرین بروزرسانی، گوگل در نتایج نویسندگی در SERPS نشان میدهد، در حال حاضر، با استفاده از فعالسازی قابلیت REL، نویسنده، مطالب خود را در جایگاه بهتری خواهد دید. جان مولر میگوید که آنها این روند را در امتیاز دهی ادامه خواهند داد. او در ادامه میگوید: دوستان آنان در گوگل نیز میتوانند سریعتر، تغییرات را دیده و مطالب آنان را در نتایج جستجو پیدا کنند. چه دوست داشته باشید و چه نداشته باشید، Google+ در این زمینه موثر است.

اگر شما در گوگل پلاس مینویسید و فعال هستید، بیشک شما دیده میشوید و این دیدهشدن حتی اگر یک لینک کوتاه یا یک عکس از وبسایت شما باشد، مهم است. به طور خلاصه، نویسندگی در سایتی که در گوگل پلاس ادغام شده است میتواند به طرز چشمگیری بر جذب مخاطب اثر مثبت بگذارد. ممکن است شما مزایای این کار را ندانید اما من به گفتهها و آموزشهای گفته شده در این مورد، My favorite tutorial is by WPBeginner بسیار علاقمند هستم.

5 – بهینه نشدن پستها در SERPs : این اشتباه شبیه به اشتباه قبلی در مورد بی اهمیتی نویسندگی در + Google است، که آن را به عنوان نرخ clickthrough که به SERPs نیز معروف است میشناسیم. ( این موضوع که توسط نویسنده مطرح شده، از آنجا که اهمیت آن از نظر گوگل زیر پرسش رفته و این احتمال وجود دارد که گوگل آن را بررسی نکند، در این مقاله ترجمه نشد. موضوع SERPs به نوعی اشاره به متاتگها و دیسکریپشن و استفاده نامحدود از آن را دارد که به نظر میرسد گوگل برای آن اهمیت چندانی قائل نیست و مدتهاست اعلام کرده که دیسکریپشن، دیگر در نتایج رتبه بندی گوگل تاثیری ندارد.

ما همیشه همراه شما هستیم

:: برچسبها:

بهینه نشدن سایت,بهینه نشدن پست ها,دسته بندی و تگ های ضعیف,تعریف نشدن ادرس های متعارف برای سایت,ارائه نشدن نقشهxml برای سایت ,

:: بازدید از این مطلب : 855

|

امتیاز مطلب : 12

|

تعداد امتیازدهندگان : 4

|

مجموع امتیاز : 4

ن : سایت سیلز

ت : چهار شنبه 31 شهريور 1395

|

|

|

مدتی پیش سری به منابع تحقیقاتی وردپرس (smashingmagazine) زدم و با جستجو در این وبسایت مرجع، به موضوع خوبی برخوردم در رابطه با بهبود سرعت سایتهای وردپرسی. موضوع از اینجا شروع شد که فردی به نام مارکوس تیلور که خود نیز از کاربران وردپرس است، بعد از اقداماتی خلاقانه متوجه میشود که سرعت بارگزاری وبسایت او از 1 ثانیه نیز کمتر شده است. مارکوس تیلور، با تحقیق در این رابطه که آیا این مورد اتفاقی بوده است و یا اقداماتی که انجام داده، اقدامات مناسبی بودهاند، متوجه میشود که اقدامات بسیار مفیدی را انجام داده است و تصمیم میگیرد که این مورد را با سایرین به اشتراک بگذارد. آنچه در ادامه میخوانید ممکن است در هیچ کجای دیگری دیده نشود و صرفا ترجمه ایست از مقاله How To Speed Up Your WordPress Website نوشته مارکوس تیلور.

دو ماه پیش برای آزمایش سرعت یکی از سایتهای خود در حدود 2 ساعت کار کردم و با حذف چند خطای ساده و نصب چند پلاگین، متوجه شدم که سرعت بارگزاری سایت من از 1/63 ثانیه به 583 میلی ثانیه کاهش یافته است که بهبودی 70/39 درصدی را نشان میدهد.

با توجه به مطالعات سال 2009 در نشریه آکامای (2009 Akamai study)، حدود 42 درصد از بازدیدکنندگان، وبسایتهایی با سرعت لود کمتر از 2 ثانیه را بازدید میکنند و حدود 57 درصد از کاربران، صفحاتی را که بارگزاری آن بالاتر از 3 ثانیه باشد را رها میکنند و میروند. از آنجا که این مطالعه هیچگونه اطلاعات آماری را تایید نمیکند اما نشان میدهد که این مورد در فروش و یا کار وبسایتها تاثیر گذار است. در سال 2006 نیز آمازون گزارش داد که یک تغییر 100 میلی ثانیهای در سرعت سایتش، درآمد این شرکت را 1 درصد تغییر داده است و گوگل نیز مدتی بعد در یک پست وبلاگی اعلام کرد که الگوریتم های گوگل، در محاسبه رنکینک وبساتها، عامل سرعت را محاسبه میکنند.

افزایش سرعت وردپرس

چگونه میتوانید سرعت وردپرس را بهبود ببخشید؟ در ادامه با دوازده مورد روبرو میشویم که سرعت بارگزاری وبسایت را به نحو چشمگیری بهبود خواهد بخشید. مهمترین آنها عبارتند از:

شناسایی افزونهها و پلاگینهایی که وبسایت را تحلیل میبرند

فشرده سازی فایلها، تصاویر، جاوا اسکریپت، Css و فایلهای دیگر

تمیز نگه داشتن پایگاه داده وبسایت وردپرسی

تنظیمات کش مرورگر در مسیر درست (در اینجا منظور از کش مرورگر، کش مرورگر خود نیست بلکه کش مرورگر بازدید کننده است. مترجم)

هنگامی که خانه شما در حال غرق شدن است، شما قطعا به فکر رنگ آمیزی یا صیقل دادن پنجرههای خانه خود نیستید چرا که باید پایههای خانه را برای جلوگیری از غرق شدن، درست کنید . همین مورد درباره وبسایتها نیز صدق میکند. زمانیکه سرور سایت تنبل است (منظور سرورهای رایگان و اشتراکی… مترجم) و یا قالب و پوسته سایت، ورم کرده و سنگین است، اقدامات بهینه سازی، کمکی نخواهد کرد، چراکه باید از پایه و اساس درست شود. بنابراین اجازه دهید با آنچه که یک پایه خوب برای راه اندازی و اجرای یک وبسایت است و با سرعت خود آغاز میشود، آشنا شویم.

شرکت میزبان وب شما و بستههای میزبانی وب تاثیر زیادی بر سرعت وب سایت شما دارد، رایگان بودن بسیاری از میزبانها و یا ارزانتر بودن آنها سوای عملکردشان میتواند جذاب باشد. اما با عقل از درک جور در نمیاید که همه چیز آنها نرمال باشد. یک نمونه را بررسی میکنیم برای دیدن چشمانداز این موضوع در دراز مدت. دو نفر از مشتریان من وبسایتهای مشابهی را تاسیس کردند اما بر روی دو میزبان متفاوت. یکی از WPEngine (شرکت میزبانی عالی) ، و میزبان دیگر وب سایت خود را در سروری بسیار ارزان قیمت (به نوعی رایگان. مترجم) به اشتراک گذاشت. زمان پاسخ DNS (یعنی زمانی که برای مرورگر طول می کشد تا به سرور میزبان متصل شود) از مشتریای که از WPEngine استفاده کرده بود 7میلی ثانیه بود. همین اتصال مرورگر به DNS برای فردی که از سرور ارزان و اشتراکی استفاده کرده بود، 250 میلی ثانیه بود. اگر شما میخواهید که وبسایت خود را با سرعت بالا بیاورید، لازم است بدانید که باید با یک پکیج خوب شروع کنید.

شوربختانه، همه پوستههای وردپرس برابر نیستند. در حالی که برخی از آنها بسیار سریع و خوب است و خوب کد نویسی شده است، بسیاری نیز با تنظیمات مختلف برای شخصی سازی و صدها رنگ و نما، ورم کرده و سنگین است. چند سال پیش، جولیان فرناندز از Synthesis ran an interesting case، مطالعه موردی جالبی را درباره قالبهای پیشفرض وردپرس و نظارت جستجوگرها بر سرعت صفحات انجام داد. او متوجه شده است که فقط با تغییر تم، زمان بارگذاری او بین 630-172 میلی ثانیه بهبود یافته است. هنگامی که شما یک تم را انتخاب میکنید، بررسی سرعت صفحه از نسخهی نمایشی موضوع، با استفاده از یک ابزار مانند Pingdom بر روی آن انجام دهید، تا ببینید که سرعت آن بدون اضافه شدن هیچ چیزی به آن (از جمله پلاگینها. مترجم) چگونه است. این کار باید به شما بفهماند که کد نویسی چگونه انجام شده است.

من به تازگی در یکی از وبسایتهای خودم، استفاده از شبکههای تحویل محتوا (CDN) را آغاز کردهام (CDN نوعی پروتکل است که کاربر را از طریق نزدیکترین سرور منطقهای به سایت شما هدایت میکند. مترجم) و متوجه کاهش 55 درصدی در مصرف پهنای باند و بهبودی بسیار عالی در سرعت بارگذاری صفحات در حال اجرا شدم.

کانادا میزبان یک شبکه بزرگ از سرور در سراسر جهان است که به عنوان CDN شناخته میشود. اگر یک کاربر از آرژانتین بازدید کننده وب سایت شما باشد، از آنجا که پهنای باند خود را در سراسر بسیاری از سرورهای مختلف پخش میشود، ممکن است در رسیدن به سایت شما تاخیر داشته باشد، CDN کاربر را به نزدیکترین سرور منطقهای رسانده و از آنجا به وبسایت شما هدایت میکند. این کار بار سرور شما را نیز کاهش میدهد. (استفاده از شبکه CDN رایگان نبوده و ماهیانه مبلغی هزینه دارد. مترجم). راه اندازی یک CDN میتواند چند ساعت طول بکشد، اما معمولا یکی از سریعترین راههایی است که به طرز چشمگیری سرعت صفحات در حال بارگذاری را بهبود میبخشد.

P3 یکی از پلاگینهای تشخیصی مورد علاقه من است زیرا به شما نشان میدهد تاثیر پلاگینهای دیگر بر سرعت صفحات در حال بارگذاری چقدر است. استفاده از این افزونه وردپرس باعث میشود شما به راحتی بتوانید پلاگینهایی که سرعت را کاهش میدهند را شناسایی کنید. (در ادامه نیز تصویری از محیط این پلاگین را میبینید. مترجم). متهم اصلی در کاهش سرعت لود صفحات، پلاگین اجتماعی به اشتراک گذاری است که اکثر آنها بر روی صفحه در حال بارگذاری، اضافه بار هستند و به راحتی میتوان با تعبیه دکمههای اجتماعی به کد منبع، موضوع را جایگزین کرد و این پلاگین را حذف نمود. هنگامی که شما از افزونههای کاهش دهنده سرعت وب سایت خود آگاه هستید، میتوانید تصمیم آگاهانهای بگیرید در مورد اینکه آیا آنها را نگه دارید، آنها را جایگزین و یا به طور کامل حذف کنید.

افزایش سرعت وردپرس

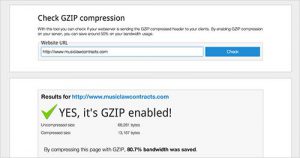

هنگامی که شما یک فایل را بر روی کامپیوتر خود با برنامه Zip فشرده میکنید در واقع حجم آن فایل را کم میکنید و میتوانید آن را سادهتر و سریعتر برای هرکسی ارسال کنید. در وبسایتها نیز همین کار را gzip انجام میدهد و دقیقا به همان شیوه اما با فایلهای صفحه وب. پس از نصب، Gzip به طور خودکار فایلهای وبسایت شما را به عنوان فایلهای ZIP فشرده میکند و باعث صرفهجویی در پهنای باند و بالا بردن سرعت صفحات در حال بارگذاری میشود. هنگامی که یک کاربر وبسایت شما را بازدید میکند، مرورگر به طور خودکار فایلهای زیپ شده را از حالت فشرده خارج کرده و محتویات آنها را نشان میدهد. این روش انتقال محتوا از سرور به مرورگر است که کارآمدتر است و موجب صرفهجویی زیادی در وقت کاربران میشود. عملا هیچگونه حرکت عملی یا دستی برای کار Gzip وجود ندارد و افزایش سرعت به نحو چشمگیری (بدون دخالت دست. مترجم) انجام میشود. همانگونه که در تصویر زیر تماشا میشود، وبسایت MusicLawContracts.com بعد از نصب Gzip از 68 KB به تنها 13 KB کاهش حجم داشته است

افزایش سرعت وردپرس

در حالی که بعضی از پلاگینها (برای کم شدن حجمشان. مترجم) از شما میخواهند Gzip را در وبسایت خود با کلیک یک دکمه اضافه نصب کنید (یا آنان را دستی زیپ کنید. مترجم)، در این حالت نیز نصب این قسمت به صورت دستی است و در واقع بسیار ساده است. فایل .htaccess خود را باز کرده (در دایرکتوری ریشه بر روی سرور خود میتوانید این فایل را پیدا کنید)، و کد زیر را به آن اضافه کنید:

AddOutputFilterByType DEFLATE text/plain

AddOutputFilterByType DEFLATE text/html

AddOutputFilterByType DEFLATE text/xml

AddOutputFilterByType DEFLATE text/css

AddOutputFilterByType DEFLATE application/xml

AddOutputFilterByType DEFLATE application/xhtml+xml

AddOutputFilterByType DEFLATE application/rss+xml

AddOutputFilterByType DEFLATE application/javascript

AddOutputFilterByType DEFLATE application/x-javascript

هنگامی که شما این قطعه کد را به htaccess اضافه کردید، باید تست کنید و متوجه شوید که آیا راهاندازی شده و کار میکند یا خیر. اگر به هر دلیلی کد بالا کار نمیکند، یکی از روشهای دیگر که پاتریک ساکستون درباره فعال کردن gzip در مقاله خود توصیف میکند را امتحان کنید.

تصاویر اکثر پهنای باند را در بسیاری از وبسایتها میگیرند. WP Smush.it پلاگین بزرگی است که به طور خودکار، کار فشرده تصاویری که در کتابخانه رسانه آپلود شده است را انجام میدهد. این پلاگین عمل فشرده سازی تصاویر را با تکنیک lossless، انجام میدهد، به این معنی که شما هیچ تفاوتی در کیفیت تصاویر را حس نمیکنید. یک چیز خوب در مورد WP Smush.it این است که منعطف کار میکند، به این معنی که اگر هزاران تصویر در کتابخانه رسانه ذخیره شده باشد، شما میتوانید همه آنها را از طریق افزونه با یک کلیک فشرده کنید.

ذخیره مرورگر یک تکنیک از روی حیله و تزویر است. تعداد انگشت شماری از پلاگینهای ذخیره بزرگ در دسترس هستند، اما اگر درست نصب نشوند، میتوانند آسیب بیشتری وارد کنند. نحوه کار به این شکل است که تاریخ انقضا هدر مرورگر میگوید که آیا برای درخواست یک فایل خاص، آن را از سرور فراخوانی کند و یا از کش مرورگر. البته این تنها زمانی کار میکند که مرورگر کاربر یک نسخه از صفحه وب شما را در حافظه خود ذخیره کرده باشد. بنابراین، این روش افزایش سرعت وب سایت، تنها برای کسانی مناسب است که همیشه از وب سایت شما بازدید میکنند و صفحات شما را ذخیره دارند. تاریخ انقضا هدر و سرعت بخشیدن به وب سایت، دو مزیت دارد. اول، نیاز به بازگشت بازدیدکنندگان برای دانلود فایلهای مشابه از سرور را دو برابر کاهش میدهد. در مرحله دوم، تعداد درخواست HTTP را کاهش دهد. برای این کار، یک پلاگین توصیه میکنم و آن هم استفاده از WP Super Cache است. با این حال طیکردن و مطالعه یک راهنمای نصب و راهاندازی این پلاگین، به شدت توصیه میشود. برای اینکه اطمینان حاصل شود که شما آن را به درستی تنظیم میکنید. متناوبا، شما میتوانید کد زیر را نیز به فایل .htaccess خود اضافه کنید.

# BEGIN WEBSITE SPEED BOOST

# Time cheat sheet in seconds

# A86400 = 1 day

# A172800 = 2 days

# A2419200 = 1 month

# A4838400 = 2 months

# A29030400 = 1 year

# Test which ETag setting works best on your Host/Server/Website

# with Firefox Firebug, Firephp and Yslow benchmark tests.

# Create the ETag (entity tag) response header field

#FileETag MTime Size

# Remove the ETag (entity tag) response header field

Header unset ETag

FileETag none

<IfModule mod_expires.c>

ExpiresActive on

ExpiresByType image/jpg A4838400

ExpiresByType image/gif A4838400

ExpiresByType image/jpeg A4838400

ExpiresByType image/png A4838400

ExpiresByType video/webm A4838400

ExpiresByType application/x-shockwave-flash A4838400

ExpiresByType application/x-javascript A4838400

ExpiresByType application/javascript A4838400

ExpiresByType text/javascript A4838400

ExpiresByType text/css A4838400

#ExpiresByType text/html A86400

# Default is 2 days below so the line above is not needed / commented out

ExpiresDefault A172800

</IfModule>

<IfModule mod_headers.c>

<FilesMatch "\.(js|css|flv|ico|pdf|avi|mov|ppt|doc|mp3|wmv|wav|gif|jpg|jpeg|png|swf|webm)$">

Header append Cache-Control "public"

</FilesMatch>

<FilesMatch "\.(txt|html)$">

Header append Cache-Control "proxy-revalidate"

</FilesMatch>

<FilesMatch "\.(php|cgi|pl|htm|xml)$">

Header set Cache-Control "private, no-cache, no-store, proxy-revalidate, no-transform"

Header set Pragma "no-cache"

</FilesMatch>

</IfModule>

<IfModule mod_deflate.c>

# Insert filters

AddOutputFilterByType DEFLATE text/plain

AddOutputFilterByType DEFLATE text/html

AddOutputFilterByType DEFLATE text/xml

AddOutputFilterByType DEFLATE text/css

AddOutputFilterByType DEFLATE application/xml

AddOutputFilterByType DEFLATE application/xhtml+xml

AddOutputFilterByType DEFLATE application/rss+xml

AddOutputFilterByType DEFLATE application/javascript

AddOutputFilterByType DEFLATE application/x-javascript

AddOutputFilterByType DEFLATE application/x-httpd-php

AddOutputFilterByType DEFLATE application/x-httpd-fastphp

AddOutputFilterByType DEFLATE image/svg+xml

# Drop problematic browsers

BrowserMatch ^Mozilla/4 gzip-only-text/html

BrowserMatch ^Mozilla/4\.0[678] no-gzip

BrowserMatch \bMSI[E] !no-gzip !gzip-only-text/html

# Make sure proxies don't deliver the wrong content

Header append Vary User-Agent env=!dont-vary

</IfModule>

# END WEBSITE SPEED BOOST

من یکی از طرفداران بزرگ autosaves (ذخیره خودکار موارد در وردپرس. مترجم) هستم، اما عیب این مورد این است که پایگاه داده سایت با هزاران ارسال بیمورد مانند تجدید نظر، قوانین، پینگ بکهای فعال، نظرات تایید نشده و اقلام دیگر تبدیل به سطل زباله میشود که سرعت بارگذاری را به سرعت کم میکند. راه حلی که برای این موضوع توصیف میشود، استفاده از افزونه فوق العادهای به نام WP-Optimize است که به طور معمول و خودکار، سطل زباله پایگاه داده را پاک کرده، پایگاه دادهای تمیز و کارآمد را منجر میشود.

اگر شما بیش از تعداد انگشت شماری از پلاگینها را نصب کردهاید، این احتمال وجود دارد که لینک وبسایت خود را به 10 تا 20 شیوه نامهی انفرادی و فایلهای جاوا اسکریپت در هر صفحه فرستاده باشید. این ایده آل نیست. قرار دادن تمام جاوا اسکریپت به یک فایل جاوا اسکریپت و تمام CSS در یک فایل CSS، بطور قابل توجهی کارآمدتر است. اینجا جایی است که کوچکسازی به کار میآید. پلاگین کوچک کردن تمام شیوه نامه شما و فایلهای جاوا اسکریپت، در یک ترکیب، تعداد درخواست مرورگر را برای فراخوانی متعدد این فایلها کاهش میدهد. من ترجیح میدهم در این مورد از WordPress Minify استفاده کنم زیرا نسبت به سایر پلاگینها کمتر تهاجمی است (که برخی از آنها باعث بروز مشکلاتی میشوند که outlines Hristo Pandjarov آن را تشریح کرده است)

بازتاب، روش استفاده شده توسط وردپرس برای اعلام به وبلاگهای دیگر است برای بروزرسانی. در حالیکه گاهی اوقات جالب است بدانید که میتوان این اعلانات و بازتابها را که سرعت را کاهش میدهند غیرفعال کرد. شما میتوانید از بخش تنظیمات آنها را غیر فعال کنید.

پیش از اینکه مرورگر بتواند کل صفحه وب را نشان دهد، محتوای اطراف تصاویر را نشان میدهد. بدون دانستن اندازه این تصاویر (یا بزرگی آن سوای حجم کمشان. مترجم) مرورگر کار سخت و طولانی را پیش رو خواهد داشت. مشخصا ابعاد تصویر، موجب صرفهجویی و راحتی کار مرورگر خواهند شد. به همین دلیل، تعیین یک مجموعه کاراکتر در هدرهای HTTP شما مفید است، به طوری که مرورگر را به صرف وقت اضافی در کار کردن وادار نکند.

لینک کردن شیوهنامه خود به عنوان نزدیک راه به بالای صفحه به طور گستردهای توصیه میشود. چون مرورگرها نمیتوانند هیچ صفحهای را پیش از مطالعه فایل Css آن مطالعه نمایند. از سوی دیگر، جاوا اسکریپتها باید پایین صفحه باشند که مانع از تجزیه و تحلیل عجولانه صفحه توسط مرورگرها قبل از لود کامل صفحه نشوند. در اکثر موارد، این مورد ساده سرعت صفحه در حال بارگذاری توسط فایل را بهینه میکند. این موضوع میتواند مسئله مهمی در وبسایتهایی باشد که به شدت بر جاوا اسکریپت تکیه دارند و در لود صفحات خود نیاز به فایلهای جاوا اسکریپت دارند.

اسپریت، در اصل یک فایل تصویری بزرگ است که شامل تمام تصاویر بزرگ فردی در کنار یکدیگر است. با استفاده از SPRITES CSS، شما میتوانید همه چیز را در یک تصویر، با مشخص کردن و نمایش مجموعهای از مختصات آن پنهان کنید. در واقع CSS SPRITES سرعت بارگزاری تمام تصاویر کوچک را در یک تصویر بزرگتر، بهتر میکند و مسلما بارگذاری یک تصویر از بارگذاری صدها تصویر کوچک راحتتر خواهد بود. سادهترین راهحل برای استفاده از این اقدام، استفاده از ابزار SpriteMe ، است که ابزاری است برای تبدیل تمام تصاویر به یک CSS SPRITE. به یاد داشته باشید که مرورگر سافاری قادر به لود تصویر خیلی بزرگ نیست.

افزایش سرعت وردپرس

فعال کردن و زنده نگه داشتن اجازه میدهد تا دستگاه مشتری برای دانلود چند فایل بدون نیاز به بارها و بارها درخواست اجازه، بتواند راحتتر کارش را انجام دهد (اشاره به لینک مستقیم. مترجم). در نتیجه صرفهجویی در پهنای باند و در نهایت بهبود سرعت را در پی خواهد داشت. برای فعال کردن این قابلیت، کد زیر را به فایل .htaccess خود اضافه کنید.

<ifModule mod_headers.c>

Header set Connection keep-alive

</ifModule>

پی اچ پی برای ساخت یک وبسایت بزرگ و کارآمد مناسب است و نیاز به وارد کردن اطلاعات چندین باره ندارد. با این حال اطلاعات از طریق پی اچ پی با استفاده از ریسورس سرور (منابع سرور) انجام میشود و باید با HTML که در آن هیچ صرفه جویی در وقت دیده نمیشود جایگزین گردد.

نتیجه گیری

انتظار میرود در 12 ماه آینده، استفاده از اینترنت تلفن همراه از دسکتاپ پیشی بگیرد. این تغییر کاربری به سمت دستگاههای تلفن همراه به این معنی است که داشتن یک وبسایت سریع هرگز به اندازهای که امروز مهم است، مورد توجه نبوده است. کاربران در حال حاضر از وب سایتها انتظار دارند سریع لود و بارگیری شود، و توسعه دهندگانی که با این موضوع منطبق نیستند در نهایت یک تجربه بزرگ سرمایه گذاری را از دست خواهند داد.

ما همیشه همراه شما هستیم

:: برچسبها:

افزایش سرعت وردپرس,دخیره کردن پایه,انتخاب یک میزبان مناسب,انتخاب پوسته مناسب,استفاده از شبکه های تحویل محتوا,فشرده سازی وب,فشرده سازی تصاویر,اهرم ذخیره مرورگر,تمیزکردن پایگاه داده ها,جاوا اسکریپت,غیرفعال کردن بازتاب,ابعاد تصاویر,فعال کردن ,

:: بازدید از این مطلب : 839

|

امتیاز مطلب : 13

|

تعداد امتیازدهندگان : 3

|

مجموع امتیاز : 3

ن : سایت سیلز

ت : چهار شنبه 31 شهريور 1395

|

|

|

زمانی که وبسایت وردپرسی خود را راهاندازی میکنید باید بدانید برای موفقیت در زمینهکاریتان راهی پر پیچ و خم دارید، برای اینکه بتوانید سریعتر به هدف خود برسید باید از موتورهای جستجو کمک بخواهید، سئو به معنای بهینهسازی برای موتورهای جستجو میباشد. یک سایت وردپرسی انعطاف بیشتری در زمینه بهینهسازی دارد. در این مقاله از وبلاگ هاستینگ ماندگار وب پنج روش برای بهبود سئو سایت وردپرس را به شما آموزش میدهیم:

زمانی که کدهای php را در قالب وبسایت خود قرار میدهید، باید بدانید که به ازای هر کد پیاچپی یک درخواست به سمت سرور ارسال میشود تا اطلاعات را دریافت کند، زمانی که تعداد درخواستها بالا برود بر مدت زمان بارگذاری سایت شما نیز اثر میگذارد برای نمونه، شما میتوانید کدهای HTML را جایگزین کدهای PHP در زمان آدرسدهی به فایلهای جاوا اسکریپت یا تصاویر کنید و تعداد درخواستهایتان را تاحدودی کم کنید. برای بررسی تعداد درخواستها و زمان آنها میتوانید از ابزار PINGDOM استفاده کنید.

در سئو اگر محتوا را پادشاه بنامیم، لینک بدون شک ملکه است!!! لینکها امتیازی ویژهای به سایت شما میدهند. یک لینک خوب جدا از اینکه باید انکرتکست مناسبی داشته باشد، باید ساختار مناسبی هم داشته باشد. به صورت پیشفرض وردپرس آدرسهای لینکها را به صورت post_Id قرار میدهد که شما باید انرا به نام نوشته تغییر دهید (بهتر است نامک را به صورت انگلیسی و یا فینگلیش وارد کنید).

وبلاگ خوبی داری به وبلاگ منم سر بزن، یادتونه؟ جملهای که اسپمرها بارها برای وبلاگهایی که داشتیم میفرستادن برای کسب بازدید و باخبر کردن شما از مطلب جدیدی که گذاشتهاند، پینگ یا ping هم همینجوره با این تفاوت که اسپم نیست دی: وردپرس در منوی تنظیمات بخش جداگانهای قرار داده برای پینگها، لیستی از پینگها در زیر آمده است:

http://blogsearch.google.com/ping/RPC2

http://ping.bloggers.jp/rpc

http://ping.cocolog-nifty.com/xmlrpc

http://ping.blogmura.jp/rpc

http://ping.exblog.jp/xmlrpc

http://ping.feedburner.com

http://ping.myblog.jp

http://ping.syndic8.com/xmlrpc.php

http://ping.weblogalot.com/rpc.php

http://ping.weblogs.se

http://pingoat.com/goat/RPC2

مطالب مرتبط:

به احتمال زیاد bounce rate یکی از فاکتورهای رتبه بندی است. میزان ماندگاری کاربر در سایت به موارد زیادی بستگی دارد که یکی از آنها مطالب مرتبط است. با استفاده از پلاگین related post در وردپرس میتوانید مطالب مرتبط را نمایش دهید.

ثبت نقشه سایت:

محتوای یک نقشه سایت، میزان آدرس و اهمیت یک لینک است که به موتورهای جستجو مطالب مهم را پیشنهاد میکند و موتورهای جستجو از طریق یک نقشه سایت میتوانند لینکهای مهم را شناسایی کنند. در وردپرس افزونههای سئو مانند All in One Seo , YOAST Seo , google xml sitemap نقشه سایت را برای شما ایجاد میکنند، که افزونه xml sitemap دست شما را در تنظیمات نقشه سایت باز میگذارد.

ما همیشه همراه شما هستیم

:: برچسبها:

ping,ساختار مناسب لینک ها,ثبت نقشه سایت,بازتاب ها,پیوندهای یکتا,کدهایphp جاگزین کدهای html ,

:: بازدید از این مطلب : 666

|

امتیاز مطلب : 7

|

تعداد امتیازدهندگان : 3

|

مجموع امتیاز : 3

ن : سایت سیلز

ت : چهار شنبه 31 شهريور 1395

|

|

|

سلام دوستان در خدمتتون هستم با معرفی یک افزونه ساده ولی حرفهای برای سئو کردن تصاویر سایت وردپرسی شما

خواص alt و title یکی از مهمترین ویژگیها برای تصاویر و مخصوصا برای گوگل هستش و این ویژگی برای افزایش ترافیک از طریق جستجوی تصاویر گوگل اهمیت زیادی داره. خودم یک افزونه قبلا دیدم seo images frinedly بود فکر کنم که میومد این تگهارو اضافه میکرد اما فقط یک عنوانه مشخصی رو و این خوب نبود ولی افزونه که دربارش صحبت میکنم میاد عنوان همون مطلبو به عنوان تگ alt و title روی عکساتون قرار میده.

این افزونه رو میتونید از اینجا دریافتش کنید.

ما همیشه همراه شما هستیم

:: برچسبها:

سئو تصویر وردپرس,سئو اسان تصاویر,سئووردپرس,سئو تصویر,seo images frinedly ,

:: بازدید از این مطلب : 670

|

امتیاز مطلب : 18

|

تعداد امتیازدهندگان : 4

|

مجموع امتیاز : 4

ن : سایت سیلز

ت : چهار شنبه 31 شهريور 1395

|

|

|

درود و عرض ادبی صمیمانه به تمامی کاربران، دوستان، دشمنان و همه افرادی که گاها با این علامت پرسش در مغز خود روبرو میشوند که چه چیزهایی در مدیریت سئو و بهینه سازی مطالب و مقالات آنها ابهام دارد. اغلب ما زمانیکه دچار ابهامات میشویم جمله معروفی را میگوییم: به جهنم. خب این یک واکنش طبیعی است برای زمانی که یک وبمستر برای پاسخ پرسشهای خود درباره سئو، جستجو کرده و با پاشخهای متناقضی مواجه میشود. مواردی را که گفته بودند خوب است را اجرا میکند و ناگهان از نتایج بد آن، شوکه میشود. کار از کار گذشته و وبسایت، مقاله، مطلب و آن مورد خاص در نتایج جستجو سقوط کرده است.

مدتی پیش ما نیز به پیروی از اینگونه راهکارها در مجموعه شخصی خود، اقدام به ویرایش مقالاتی کردیم که تا آن زمان در صدر نتایج جستجو قرار داشت و دارای تمام فاکتورهای لازم (تازگی، اختصاصی بودن، رعایت تمام موارد مربوط به بهینه سازی) بود. اما در کمال شگفتی تماشا کردیم که نه تنها همه موارد ویرایش شده، بلکه کل مجموعه در مدت زمانی کمتر از 30 روز، دچار چنان رکود و سقوطی شد که علاوه بر خسارتهای مالی، در نوع خود ابهام برانگیز بود. با کمی جستجو متوجه شدیم که این ابهام برای بسیاری از همکاران نیز رخ داده و همگی مجموعا سرگردان برای پیدا کردن پاسخ این پرسش میگردند که بهینه سازی یا نابودی؟

با این انگیزه تصمیم گرفتم به سراغ شخصی بروم که به نظرم در این زمینه، Number1 به شمار میرفت. شاید هم اکنون در ذهن بگویید که اوه، باز هم پرسش و پاسخی از یک سئو کار. خیر چنین نیست، ما با ایمان به اینکه موضوع سئو، موضوعی بسیار پیچیده است به سراغ مسئول و مدیر بخش ضد اسپم گوگل، آقای مت کاتز رفتیم تا از ایشان در ارتباط با یکی از موارد ابهام آمیز در سئو بپرسیم و پاسخ آن را یک بار برای همیشه، دریافت کنیم. این ابهام و این پرسش در سئو این بود: بهینه سازی یا نابودی؟ آیا ویرایش و دستکاری مطالب قدیمی و منتشر شده، باعث سقوط آن مطلب در نتایج میشود و یا موضوع چیز دیگریست؟

مت کاتز، در ابتدا از الگوریتمهای کمپانی صحبت میکند و مخصوصا الگوریتمهایی مانند Hummingbird algorithm (مرغ مگس خوار) و Panda Algorithm که نسخه سوم آن نیز معرفی شده است و در ادامه میگوید: مطالب لگد مال شده برای براوزرها ارزشی ندارند، حتی اگر آن مطلب بسیار غنی باشد (Content for browsers downtrodden have value , even if it is , is very rich). در پاسخ به پرسشی مبنی بر اینکه آیا منظور از موارد لگد مال شده، مطالب ویرایش شده است، مت کاتز میگوید: بله، مواردی که از دید روبات عبور کرده، تایید شده، رتبه دریافت کرده و سپس مورد هدف قرار گرفته است (Yes , when the robot vision passed , approved , and then get out of the targeted).

این پاسخ تا حدی واضح بود که بتوانم پرسش بعدی خود را درباره علت این موضوع مطرح نمایم. پرسش اینگونه مطرح شد: چرا چنین میشود؟ آیا تکمیل کردن و یا غنیتر کردن یک مورد و اضافه کردن موارد تازهتر و یا حذف موارد بدتر، از یک مورد انتشار یافته و قدیمی، از دید الگوریتمهای خشن، کار خلافی محسوب میشود؟ آقای کاتز چنین پاسخ میدهد:

اگر موردی بعد از حداکثر 25 روز در موتورهای جستجوگر، جایگاه خود را پیدا نکرد بهتر است به کلی حذف شده و ویرایش نشود، چرا که این کار از دید پاندا 3 نوعی تلاش مجدد در جهت اخاذی از خود میداند. اما در رابطه با اضافه کردن مورد تازهتر، باید بگویم که روباتها در بسیاری از موارد به وبسایتها و مطالب آنان (به ویژه وبسایتهایی با سابقه خوب در موتورهای جستجو) در ارزش گذاری، ممکن است ارفاقهایی را بدهند (بر اساس تعداد دیگر نوشتههای مشابه از جانب رقبا) که برای افراد کافی به نظر نیاید. لذا این افراد با هدف بهبود جایگاه، اقدام به دستکاری میکنند. این دستکاری مورد هدف را در معرض قضاوت مجدد ربات قرار داده و اینبار بسیار جدیتر و بیرحمانهتر. و در نتیجه توصیه میشود که جایگاه اولیه مطلب در نتایج، پذیرفته و مطالب قدیمی که ایندکس نشدهاند، به جای ادیت شدن به کل حذف گردند.

If the item after 25 days in search engines , did not find its place , it is completely deleted and can not be edited . This is the view of the Panda 3 , a second attempt to extort money from its own

من تا حد زیادی، پاسخ این ابهام را برای همیشه دریافت کرده بودم. تصمیم گرفتیم این گفتگوی کوتاه اما بسیار مهم را منتشر نماییم تا شاید یکی از بزرگترین ابهامات سئوی مطالب قدیمی را با همین گفتگوی کوتاه از زبان مردی که اسپم نویسهای اینترنت از او متنفرند و آنان که تمیز کار میکنند، او را دوست دارند پاسخ داده باشیم. امید که این موضوع، برای هیچ وبمستر ایرانی، باعث سقوط مطالب نشده و همه دوستان، همکاران و فعالین این حوزه، دوست، یار و پشتیبان هم باشند. با تشکر ویژه از خانم مهندس نگین فرمانی که زحمت ترجمه همزمان این گفتگو را کشیدند و دکتر شیدا حسنی که محبت کردند و هزینههای این گفتگو را پرداخت نمودند. ما همیشه همراه شما هستیم

:: برچسبها:

الگوریتم گوگل پاندا,الگوریتم مرغ مگس خوار,بهینه سازی,ویرایش مطلب,سقوط مطلب,غنی ویرایش پست قدیمی,بهینه سازی پست قدیمی,الگوریتم خشن,دلیل سقوط مطلب ویرایش شده,سقوط مطلب قدیمی ,

:: بازدید از این مطلب : 611

|

امتیاز مطلب : 7

|

تعداد امتیازدهندگان : 3

|

مجموع امتیاز : 3

ن : سایت سیلز

ت : سه شنبه 30 شهريور 1395

|

|

|

با نام و یاد خدا، موضوعی که در این ساعت قصد پرداختن به آن را داشتم، علت یا علل عدم موفقیت وبسایتهای بزرگ ایرانی در کسب جایگاههای جهانی بود که بنا بر دلایلی، این موضوع را به فرصت دیگری موکول کرده و در این ساعت به مبحث مهمتری خواهم پرداخت که بیشک پرسش بسیاری از مخاطبین نیز بوده و خواهد بود.

ضعفهای الگوریتمهای گوگل، موضوعی که شاید خود مسئولین کمپانی نیز از آن آگاه بوده و هستند و اما به دلایل تجاری و بیزنسی، هرگز به زیر بار این ضعفها نرفتهاند. در این نوشته میخواهیم این موضوع را بیشتر تشریح نماییم و در نهایت خواهیم دید که بسیاری از آسیبهایی که به وبسایتها وارد میشود، نه نتیجه کار غیرحرفهای و نه نتیجه سهل انگاری مدیران و نه نتیجه عدم مدیریت صحیح و نه نتیجه عدم کیفیت سرورها و دامنهها و زیر دامنهها و نه نتیجه استاندارد نبودن و بلکه نتیجه ضعف الگوریتمهایی است که وظایف مختلفی را باید به عهده داشته باشند که این وظایف را گاها با ضعفهای آشکاری، کامل و درست به پایان نمیرسانند و وبسایتهایی بیمسئولیت، خلافکار، اسپم نویس، سارق آثار پژوهشی و… بهراحتی از این ضعفها استفاده کرده و الگوریتمهایی را که در تبلیغات و معرفی آنان، به عنوان غولهای کمپانی معرفی شدند را دور میزنند و در جایگاه هایی قرار میگیرند که شایسته آنها نیست . الگوریتم ها را کم و بیش میشناسیم و از تکرار مجدد تعاریف و کار و وظایف آنها خودداری کرده به سراغ اصل موضوع میروم.

به نظر میرسد که کار این الگوریتم، مبارزه با کمپین لینک بوده و جریمه وبسایتهایی که از جایگاه خود سو استفاده کرده و لینک میفروشند و آنها که این لینکها را میخرند. این الگوریتم وظایف دیگری نیز دارد که جای بحث آن اینجا نیست. خب ببینیم که ضعف این الگوریتم چیست؟ فرض میکنیم که وبسایتی دارای رتبه عالی بوده و برای مثال پیج رنک 5 دارد و با این امکان، اقدام به فروختن لینک و یا راهاندازی کمپین لینکها در سایت خود نموده است. تا اینجا به ظاهر، گوگل با یک وبسایت خلافکار (طبق قوانین کمپانی) روبروست و الگوریتم پنگوئن، موظف است بعد از شناسایی و پیبردن به خلاف این وبسایت، آن را طبق اطلاعیهای که در معرفی این الگوریتم ارایه شد، جریمه کرده و جایگاه آن را گرفته و از آن پس نیز هرگز ارتقا ندهد. خب تا اینجا بسیار هم عالیست. اما مشکل کجاست؟ مشکل جاییست که پنگوئن، تر و خشکها را با هم میسوزاند و در واقع توان دنبال نمودن لینکهایی که در کمپین لینک وبسایت خلافکار بوده را ندارد.

پنگوئن تمام لینکهایی را که در کمپین بودهاند را به عنوان خریداران لینک شناسایی و آنان را نیز جریمه میکند. ایراد کار چیست؟ ایراد از آن جایی نشات میگیرد که بسیاری از لینکهای قرار داده شده در کمپینها میتوانند با هدف تخریب سایر وبسایتها قرار داده شده باشند، بدون اینکه مسئولین آن، خلافی را مرتکب شده باشند و نمونه آن، وبسایتهای ثبت لینک، تبادل لینک و سایر وبسایتهایی است که چه لینک را میفروشند و چه رایگان عرضه میکنند. رقبایی که توان رقابت سالم در محیط را ندارند، با پی بردن به این ضعف بزرگ پنگوئن، از این هربه برای آسیب رسانی به وبسایتهای دیگر استفاده کرده و به راحتی این الگوریتم را دور زده و به آن به غلط تفهیم میکنند که سایت مقصد، خریدار بوده و خلافکار است و پنگوئن نیز، از آنجا که توان دنبال نمودن و پیبردن به اصل ماجرا را ندارد، به سرعت تمامی لینکها را با چشم بسته جریمه میکند. نتیجه این میشود که فردی درستکار با وبسایتی بدون 1 خط اسپم، میگوید که نمیدانم چرا وبسایتم پیشرفت نمیکند.

موضوع بعدی در رابطه با بخش بیزنسهاست که خواهیم دید چگونه گوگل، بر خلاف شعار خود، کیفیت را فدای درآمد میکند. در این کمپانی، دو بخش Google Adwords و Google Adsense که به ترتیب مسئول دریافت تبلیغات سازمانی و شخصی در امور وبسایتها هستند، به نحو چشمگیری با بخش ضد اسپم این کمپانی ارتباط دارند. این دو سرویس که درآمد کل کمپانی نیز به میزان 10 میلیارد دلار در 8 سال پیش (یعنی تنها در سال 2006) و 16 میلیارد دلار در سالهای اخیر، را تامین میکنند (گزارش ادوارد سیک در آنوال ریپورت http://www.webcitation.org/61rPRmWhL) به اَشکالی گوناگون نشان دادهاند که آن دسته وبسایتها که هزینه میکنند، میتوانند به نوعی از الگوریتمها نیز عبور نموده و فارغ از محتوای خود (چه اسپم چه محتوای سرقتی چه تازه و نوآورانه) جایگاههای خوبی را برای خود دست و پا نمایند و آن دسته وبسایتها که هزینه نمیکنند را به راحتی لگد مال نمایند. نتیجه چه میشود؟ فردی برای نمونه، عبارت مقالات وردپرس را در این موتور جستجوگر سرچ میکند و به ردیف، محتویاتی را خواهد دید که همگی از روی یکی کپی برداری شدهاند، خب قضیه جالبتر مانده و آن این موضوع است که در صفحات سوم و چهارم و پنجم از نتایج جستجو، با تعجب به موارد تازه و جدیدی بر میخورد. این به چه معناست؟ گوگلی که خود وبسایتها را از خرید بک لینک بازداشته و مجازات میکند، خود مقولهای به نام پیج رنک را در معرض فروش قرار میدهد و آشکار و پنهان، این موضوع را القا میکند که میتوانید پول بدهید و فارغ از کیفیت محتوای خود، جایگاههای خوب را کسب کنید. اگر به نشریه خوارزمی در 21 سپتامبر 2011 هم نگاهی داشته باشیم که گوگل از کلیک بر هر لینک تبلیغاتی 60 سنت سود میکند، این روند هم منطقی به نظر میرسد که محتوای لینکی که تبلیغات داده است، میتواند برای گوگل بیاهمیت باشد. البته در این نکته که تبلیغات بسیار هم خوب است شکی نیست اما اینکه تبلیغات هر محتوایی از نظر گوگل، یکسان تلقی و یکسان مورد لطف قرار میگیرد، نه تنها یک ضعف برای الگوریتمها بلکه یک ضعف اساسی و ناعادلانه برای کل کمپانی گوگل محسوب میشود که فضای رقابت سالم را به فضای جنگ سرمایه تبدیل میکند. این یک اتهام نیست، بلکه واقعیتی است که وجود دارد، چه ما بر سر و کله یکدیگر بکوبیم و چه نکوبیم، این مورد وجود دارد.

خب به الگوریتم پاندای گوگل میرسیم. الگوریتمی که شاید وقتی نسخه سوم آن معرفی شد، همگان فکر کردند که از شر کپی کنندگان راحت شدند در حالی که چنین نبود و در ادامه خواهیم دید که کپیکنندهها و سارقان آثار، چگونه این الگوریتم را دور میزنند. پاندا 3 در واقع چیز جدیدی نبود، بلکه به نوعی در آن تلاش شد ضعفهای نسخههای قدیمیتر، اصلاح شود. با ورود این الگوریتم، از آنجا که ما در ایران 70 میلیون نفر بهینهساز داریم، این الگوریتم، غول مبارزه با کپی برداران محتوا و سارقان آثار منتشر شده معرفی شد. عدهای به شکلی ماهرانه که نشان داد همیشه خلافکارها یک قدم جلوتر از الگوریتمها هستند، با نامنویسی در خبرنامههای وبسایتهای درستنویس و تمیزکار، بلافاصله از ورود محتوای جدید به سایتها آگاه شده و در دم اقدام به های لایت و کپی مطلب در وبلاگ و یا وبسایت خود (که سابقا نیز با تبلیغات بالاتر از آن وبسایتها قرار گرفته بود) کرده و به نوعی پاندا 3 و جانورهای گوگل و روباتها و عنکبوتهای کند گوگل را، پیش از رسیدن به آن مطلب، دور میزنند و آن مقاله و مطلب را به نام وبسایت خود، به عنوان محتوای تازه، منتشر میکنند . نتیجه چه میشود؟ پاندا و روباتها کند هستند، کندتر از خلافکاران، وبسایت اصلی جریمه میشود و وبسایت سارق تقدیر شده و لینکش در جایگاه بهتری قرار میگیرد. مدیران وبسایت جریمه شده بعد از چند روز، لینک خود را در ته نتایج دیده و یا همان مطلب را در رتبه اول اما با آدرس دیگری تماشا میکنند. این به نظر عادلانه نمیرسد، اما ما باور داریم که فضا، فضای رقابت سرمایه است و نه رقابت نوآورانه و سالم و منطقی و تمیز.

این الگوریتم که سالهای زیادی از عمر آن نمیگذرد، به نوعی آمده است تا خلاف تمام گفتههای ما در این مقاله را اثبات نماید. اما هنوز نیامده ایرادی از جانب پارسی زبانان به آن وارد شد که جای تامل داشت. این الگوریتم، زبان پارسی را به درستی تشخیص نمیدهد و تعدادی از واژههای پارسی مانند ک و ی و گ و پ را به شکل عربی آن (ي) و (ك) مورد تحلیل قرار میدهد که در نتایج کار آن در وب پارسی، یک ضعف محسوب میشود. این الگوریتم از آنجا که هنوز آنطور که باید و شاید مورد مطالعه قرار نگرفته، و از طرفی هدف آن توجه بیشتر به محتوا اعلام شده است، کار خود، ادعای گوگل، ضعفها و نقاط قوت خود و سایر موارد را در آینده بهتر نشان خواهد داد.

ما همیشه همراه شما هستیم

:: برچسبها:

الگوریتم گوگل پنگوئن ,Google Penguin algorithm,الگوریتم گوگل پاندا,الگوریتم مرغ مگس خوار,بررسی ضعف های گوگل,سقوط وبسایت ها, ,

:: بازدید از این مطلب : 645

|

امتیاز مطلب : 16

|

تعداد امتیازدهندگان : 4

|

مجموع امتیاز : 4

ن : سایت سیلز

ت : سه شنبه 30 شهريور 1395

|

|

|

فروش ورودی گوگل

به کاربری که از طریق سرچ کلمه ای در وبسایت جستوجوگر گوگل در نتایج بعمل امده سایت شما را انتخاب کرده و وارد شود ورودی گوگل می گویند

ورودی گوگل ورودی گوگل

ورودی گوگل چیست و چگونه می توان از ویژگی ها و توانمندی های آن مطلع شد؟

گوگل یکی از بهترین فضاها را برای راحتی کاربران اینترنتی فراهم ساخته است تا بتوانند از اینترنت به بهترین شکل برای رسیدن به اهداف خود استفاده نمایند. این امر از قدم نخست استفاده از اینترنت امکان پذیر می باشد که شما به راحتی با پیشنهاداتی از گوگل مواجه می شوید تا بتوانید آنچه را که در نظر دارید پیدا نمایید.

از توانمندی های گوگل در جهت ایجاد بهترین کسب و کار نیز می توان استفاده نمود که این امر در جهت انجام تبلیغات و بازاریابی کاربردی می باشد که شما با آموزش های تخصصی می توانید از این عوامل بهره مند شوید.

به کاربری که از طریق سرچ کلمه ای در وبسایت جستوجوگر گوگل در نتایج بعمل امده سایت شما را انتخاب کرده و وارد شود ورودی گوگل می گویند

گوگل چیست؟

گوگل شرکتی آمریکایی است که از طریق تبلیغاتی که به همراه خدمات متنوع خود ارائه میکند و یا فروش همان خدمات، بدون فرستادن تبلیغات، کسب درآمد میکند. این خدمات شامل مواردی چون جستجوی اینترنتی، ایمیل، نقشه برخط، نرمافزارهای اداری، شبکههای اجتماعی و اشتراک فایلهای ویدئویی میشود.

صفحه اصلی گوگل در سال1998

تاریخچه گوگل

دو دانشجوی دکترای دانشگاه استنفورد، یعنی لری پیج و سرگئی برین، گوگل را در سال ۱۹۹۸ تأسیس کردند. این شرکت خصوصی در ماه ژوئن ۱۹۹۹ / تیر ۱۳۷۹ رسمأ با سرمایه تأسیس ۲۵ میلیون دلار معرفی شد. این شرکت همراهانی را چون کلاینر پرکینز کاوفیلد و سیکوال کپیتال را پیدا کرد. گوگل سرویس و خدمات عمومی اصلی خود را در وب سایت خود در www.google.com ارائه میدهد. این شرکت همچنین سرویس جستجوی پیشرفته را برای فراهم سازی اطلاعات محتوایی نیز ارائه میدهد.

معنی گوگل

گوگل بر گرفته شده از کلمه Googol که به معنی «یک عدد یک و صد صفر جلوی آن» است که توسط میلتون سیروتا پسر خواهر ادوارد کاسنر ریاضیدان آمریکایی اختراع شدهاست. این موضوع «یک عدد یک و صد صفر جلوی آن»، نوعی شعار و در واقع مقصود موضوع است. بدین معنی که گوگل قصد دارد تا سرویسها، اهداف و اطلاعرسانی و اطلاعات خود را تا آن مقدار در وب در جهان گسترش دهد.

خدمات گوگل

جستجو (Google search)

جیمیل (Google Mail-Gmail)

نوار ابزار گوگل (Google Toolbar)

گوگل مپس (Google Maps)

گوگل مون (Google Moon)

گوگل مارس (Google Mars)

گوگل ارت (Google Earth)

گوگل کروم (Google Chrome)

گوگل تاک (Google Talk)

گوگل باز (Google buzz)

گوگل داکز(Google Docs)

گوگل بوکز

گوگل ویدئو (Google Video)

گوگل ریدر (Google Reader)

نول (Knol)

ابزار مدیر سایت (Webmaster Tools)

تحلیلگر سایت (analytics)

بلاگر (blogger)

آلبوم وب پیکاسا (Picasa Web Albums)

فیدبرنر (FeedBurner)

گوگل نوتبوک (Notebook)

گوگل سایت (Sites)

گوگل ترندز (Trends)

گوگل تلفن همراه (Mobile)

گوگل ادسنس (Google AdSense)

گوگل ترنسلیت (Google Translate)

گوگل داشبورد (Google dash board)

گوگل تی وی (Google TV)

نکته: ما همیشه همراه شما هستیم

:: برچسبها:

ورودی گوگل,خرید ورودی گوگل,ورودی گوگل ارزان,ورودی گوگل هدفمند,تبلیغات گوگل,ورودی گوگل تضمینی,گوگل ادسنس,گوگل ترنسلیت,گوگل داشبورد,گوگل تی وی,گوگل تلفن همراه ,

:: بازدید از این مطلب : 682

|

امتیاز مطلب : 12

|

تعداد امتیازدهندگان : 4

|

مجموع امتیاز : 4

ن : سایت سیلز

ت : دو شنبه 29 شهريور 1395

|

|

|

کوچ از تلگرام

تلگرام تلگرام

سلام / این بار با خبری در خصوص خداحافطی از تلگران (به زودی) در خدمت شما هستیم ... این خبر برای علاقه مندان به اخبار تلگرام خبر بدی خواهد بود . اما این اتفاق ، اتفاقی هست که برای هر سیستمی ممکن است رخ دهد . تلگرام در ایران رشد فوق العاده ای داشته است ،

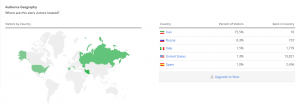

نرم افزار پیام رسان تلگرام . یک نرم افزار هست که توسط روسی زبانان طراحی و تولید شده است . اما جالب است بدانید که از مردم این کشور تنها 10% درصد از این اپلیکیشن استفاده میکنند . و بیش از 40% تلگرام رو ایرانی ها استفاده میکنند .

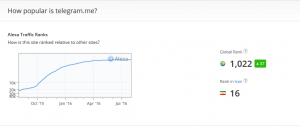

تلگرام دارای دو دامنه اصلی است (telegram.org - telegram.me) استفاده از تلگرام به حدی در ایران بالا هست که دو دامنه نرم افزار پیام رسان تلگرام تنها با حدود دو سال فعالیت توانسته اند در جایگاه های 14 و 16 الکسای ایران قرار بگیرند . دامنه تلگرام دات او ار جی دارنده رتبه 14 ایران هست و بیش از 40 درصد ان را ایران استفاده میکند و بعد از ایران 20 درصد از ان را کشور های : روسیه ، ایتالیا ، اسپانیا ، آلمان (10 درصد روسیه (Russia) ، ایتالیا (Italy) نزدیک به 6 درصد ، ،آلمان (Germany) نزدیک به 4 درصد - اسپانیا (Spain) نزدیک به 5 درصد ) استفاده میکنند ، و 40% درصد ان را هم کشور های دیگر .

و دامنه telegram.me رتبه 16 ایران است - امار های این دامنه خیلی جالب تر از دامنه فوق هست .

آیا این که یک سایت روسی زبان به حدی در ایران محبوب شود که به جای رنکنیگ روسیه . رنکینگ ایران بگیرد . جالب نیست ؟!

بخش جالب این دامنه این است که بیش از 75% درصد استفاده از سمت ایران هست و تنها 25% درصد ان را کشور های دیگر استفاده میکنند ... دامنه telegram.me بیشتر برای کانال های تلگرام - گروه های تلگرام - استیکر های تلگرام هست . این یعنی این که بیشترین میزان استفاده از گروه های تلگرام - کانال های تلگرام و... در ایران هست .

که البته دلایل اون هم مشخص هست . بستر های ایرانی در ایران به این صورت قبلا وجود نداشته است و این کمبود در حال حاظر از این سمت در حال تامین شدن هست . تلگرام تبدیل شده به وسیله ای که خیلی راحت کل مردم میتونند با هم دیگه دائم به شیوه های مختلف در ایران ارتباط داشته باشند . قبلا چنین بستری بدون هزینه به این صورت وجود نداشته است پس چنین اماری میتونه طبیعی باشه و باتوجه به این که در کشور های دیگر چنین بستر های بسیار زیاد می باشد . کاربران آنها خیلی تلگرام براشون مهم نبوده است .

بخش جالب تر تلگرام این هست . که بیشترین کلماتی که در حوزه تلگرام هم حتی سرچ میشه مربوط به سایت های ایرانی هست :

این امار مربوط به سایت telegram.org می باشد . و امار زیر مربوط به سایت telegram.me می باشد .

خیلی در کل امار ها جالب هست که تلگرام در کمترین زمان توانسته است جز 10 سایت پزبازدید ایران شود . در خصوص این امار ها میتونیم خیلی تحیلیل و بررسی داشته باشیم ولی از انجایی که این خبرخیلی طولانی خواهد شد . در این جا تصمیم گرفتم این خبر رو به چند بخش تقسیم کنم . و امروز بخش اول این خبر رو منتشر خواهیم کرد و در صورت استقبال بخش های دیگری از این خبر رو نیز اماده خواهیم کرد .

امار های این گونه در خصوص تلگرام خیلی منتشر شده است و بسیار جالب توجه هستند ولی این امار ها اصلا برای ایران خوب نیست که در خصوص دلایل ان احتمالا در جریان هستید و بارها نیز در گفتگو های تلویزیونی ، سیمنار ها و همایش های بزرگ و.. توضیح داده شده است .

یک روز بعد از اینکه اخباری درباره هک حساب تلگرامی ۱۵میلیون ایرانی منتشر شد، (پاسخ سخنگوی تلگرام به خبر هک 15 میلیون شماره تلفن کاربران ایرانی) علاوه بر اینکه تلگرام به این موضوع واکنش نشان داد و مدعی شد این واقعه به شدت ادعا شده نبوده و تنها داده های قابل دسترس به طور عمومی جمع آوری شده است، دبیر کارگروه تعیین مصادیق محتوای مجرمانه (*****ینگ) نیز گفت : «ناگزیریم یک روزی از شبکه های اجتماعی خارجی دل بکنیم.»

البته قبلا هم مسائلی در خصوص *****ینگ تلگرام و تقریبا پایان کار تلگرام در ایران مطرح شده بود . اما به نظر می رسد این بار موضوع جدی تر هست و تلگرام در ایران در حال تبدیل شدن به یک مشکل هست . مسئولان در حالی شهروندان ایرانی را به یک کوچ اینترنتی دیگر تشویق میکنند و از آنها میخواهند از شبکههای اجتماعی و پیام رسانهای داخلی استفاده کنند که کارشناسان، برخی دلایل از جمله جذابیت پایین شبکههای اجتماعی و پیامرسانهای داخلی را دلیل عدم استقبال از آنها قلمداد میکنند.

باتوجه به این مسائل به نظر می رسه همه چیز برای یک کوچ اینترنتی دیگر آماده است . همه چیز به جز این که این بار مشخص نیست قرار هست کوچ به کجا باشد . این بار نمی دانیم که قرار است از تلگرام به کجا گوچ کنیم ....

امیدواریم مفید واقع شده باشد . در صورتی که شما هم در این خصوص نظری دارید میتوانید نظرات خود را با ما در میان بگذارید .

منبع:سایت سیلز

نکته: ما همیشه همراه شما هستیم

:: برچسبها:

تلگرام,اموزش تلگرام,فیلتر شدن تلگرام,کوچ از تلگرام,قطع شدن تلگرام,تلگرام مسنجر محبوب,تلگرامی ها ,

:: بازدید از این مطلب : 718

|

امتیاز مطلب : 12

|

تعداد امتیازدهندگان : 3

|

مجموع امتیاز : 3

ن : سایت سیلز

ت : دو شنبه 29 شهريور 1395

|

|

|

بهبود سئو سایت وردپرس بهبود سئو سایت وردپرس

ابزار برای بهبود سئو سایت وردپرسی شما

فاکتورهای زیادی برای رتبه بندی وجود دارد، تمام آن چیزهایی که معرفی شدهاند تنها فرضیهاند و گوگل هنوز فاکتوری را معرفی نکرده است. ابزارهای زیادی وجود دارند که شما را در روند بهبود بهینه سازی و سئو سایتتان کمک میکنند، در این مقاله به تعدادی ابزار برای بهینه سازی اشاره میکنیم:

Google keyword-planner: سرویس جدید گوگل که جایگزین سرویس پیشین گوگل شده، وظیفه این ابزار بررسی بازدید کلمات کلیدی و پیشنهاد کلمات به وبمستر بصورت رایگان است. از این ابزار استفاده کنید تا بهترین کلمات کلیدی را برای وبسایت خود انتخاب کنید.

OpenSiteExplorer: این ابزار توسط شرکت MOZ طراحی شده است، کار این ابزار بررسی لینکهای یک وبسایت، انکرتکستها، تعداد و کیفیت دامنهها و… است که در وبسایت آن میتوانید تماشا کنید اما دقت کنید در روز 5بار حق استفاده از این ابزار را دارید و این 5بار هم تعداد محدودی لینک را به شما نمایش میدهد. برای استفاده بدون محدودیت از این ابزار و سایر ابزارهای شرکت MOZ باید حداقل 90دلار در ماه برای آن پرداخت کنید!!

PINGDOM TOOLS: زمانی که وبسایت خود را طراحی میکنید بهتر است تعداد درخواستهایی که به سمت سرور ارسال میشوند را متوجه شوید و سعی کنید تا حد ممکن آنها را کم کنید، این ابزار تعداد درخواستهای ارسال شده به سمت سرور و مدت زمان هر یک را برای شما نمایش میدهد. (پیشنهاد میکنم اگر مقاله ما با عنوان 5 روش برای بهبود سئو وردپرس را نخواندهاید حتما مطالعه کنید.)

Page speed Insight: این ابزار توسط گوگل و برای شناسایی عواملی که سرعت وبسایت را کاهش میدهند طراحی شده است نمونه دیگر این ابزار GTmetrix است که مزیت آن نسبت به این ابزار گوگل محدود نبودن برای کاربرای ایرانی است.

Keyword position: این ابزار برای پیدا کردن رتبه یک کلمه کلیدی استفاده میشود، آدرس وبسایت خود،کلمه کلیدی مورد نظر، موتورجستجو مورد نظر و محدوده صفحات را تعیین کنید تا این ابزار به شما بگوید چه رتبهای در چه موتور جستجویی دارید.

نکته: ما همیشه همراه شما هستیم

:: برچسبها:

سئو سایت وردپرس,سئو سایت,سئو وردپرس,بهبود سئو,ابزار سئو وردپرس,ابزار سئو سایت,Google keyword-planner,OpenSiteExplorer,PINGDOM TOOLS,Page speed Insight,Keyword position ,

:: بازدید از این مطلب : 677

|

امتیاز مطلب : 14

|

تعداد امتیازدهندگان : 3

|

مجموع امتیاز : 3

ن : سایت سیلز

ت : دو شنبه 29 شهريور 1395

|

|

|

الگوریتمهای بینگ و تفاوت آن با الگوریتمهای گوگل

درودی دوباره همراه با دنیا دنیا عرض ادب و احترام به تمامی عزیزان و دوستانی که در رابطه با الگوریتمهای بینگ و یاهو پرسیده بودن. در این مطلب تلاش خواهم کرد، مختصر و مفید، این الگوریتمهای ناشناخته را معرفی کرده و به جستجوی تفاوتها و شباهتهای آن با الگوریتم های گوگل بپردازم. امید که مورد مطالعه و استفاده باشد. این نوشته، ترجمه ایست از سری مقالات JOURDAN ROMBOUGH، نگارنده با رعایت اصل امانت داری در ترجمه، اقدام به تالیف در بخشهایی که نیازمند توضیحات بیشتر جهت درک بهتر موضوع برای مخاطب پارسیزبان بود را نموده است.

بیشتر، نام اینترنت را با نام گوگل میشناسیم. جای تعجبی نیز دارد. در سال 2013 تا کنون، 67 درصد از سهم بازار جستجو را در اختیار دارد. به نظر میرسید که موتور جستگوگر بینگ، به عنوان تعقیب کننده گوگل و یاهو به عنوان رقیب گرفتن تبلیغات، به سرعت از سال 2013 به بعد دریافتند که لازم است در ادغامی به جا، در مقابل یکدیگر قرار نگرفته و در کنار یکدیگر ادغام شوند تا شاید سهم بیشتری از بازار را تصاحب کنند. نتیجه این ادغام برای وبمستران خبر خوبی بود و به خصوص وبمستران ایرانی که دائما با محدودیتهای یاهو برای کشور ایران مواجه بود. بینگ و یاهو با ادغام شدن در یکدیگر، موفق به تصرف 17 درصد از سهم بازار نت شدند. این سهم از بازار کلیک، شاید برای کاربران عادی اینترنت، قابل چشم پوشی و حتی مضحک بیاید، اما بی شک برای یک وبمستر اینگونه نیست و یک وبمستر موفق، این سهم 17 درصدی را نادیده نمیگیرد.

چگونه میتوان صفحات وبسایت را در بینگ و یاهو ثبت کرد؟ پرسش خوبیست اما پیش از هر پاسخی، لازم است وبمستر با الگوریتمهای سختگیر بینگ و یاهو آشنایی داشته باشد (که در ادامه به آن میپردازم) و در قدم دوم، وبسایت خود را به درستی و نه فقط با ارسال یک آدرس برای آنها (که اغلب نادیده گرفته میشود) در این دو موتور جستجوگر ثبت کرده و نقشه سایت خود را به آنان معرفی نماید.

الگوریتمهای بینگ و یاهو چیست و چه تفاوتهایی با الگوریتم های گوگل دارد

ثبت محتوای چند رسانهای:

الگوریتمهای بینگ، اغلب جهت ثبت محتوا و صفحات حاوی پروندههای چند رسانهای طراحی شدهاند و بی شک در ثبت محتوای چند رسانهای، محیط مناسبتری نسبت به گوگل دارند و اغلب نیز جهت جستجوی این محتوا به بینگ و یاهو مراجعه میکنند (اغلب جستجوگران غیر ایرانی). الگوریتم بینگ، محتوای چند رسانهای را میتواند از نقشههای سایت پیدا کرده و به سرعت ثبت نماید، اما لازمه این ایندکس این است که وبسایت در وبمستر تولز بینگ، به ثبت رسیده باشد که در انتهای این مطلب نیز روش ثبت سایت در بینگ وبمستر را توضیح خواهم داد. پس در قدم اول، در اولین تفاوت فهمیدیم که الگوریتمهای بینگ، محتوای چند رسانهای وبسایتها (عکسها و ویدئوها، فایلهای فلش و…) را بسیار بهتر از الگوریتمهای گوگل ایندکس میکند. اما علت چیست؟ علت این موضوع نیز آن است که الگوریتمهای گوگل، به محتوای HTML بسیار وابسته هستند و این به معنی آن است که محتوای چندرسانهای اغلب توسط آنها به سختی ایندکس شده یا به کلی ایندکس نمیشود، تا جایی که طراحان افزونه سئو یاست، در تنظیمات آن اعلام کردند که بخش رسانه از نقشههای سایت تیک خورده و حذف شود.

این موضوع برای صاحبان وبسایتهای فلش و وبسایتهایی که قالب فلش دارند، بسیار مخرب است، میتوان با اضافه کردن تغییراتی، فلش و چند رسانهایها را نیز تمام و کمال به گوگل معرفی کرد، اما گوگل معمولا از محتوای چندرسانهای استقبال نمیکند و این در حالیست که بینگ و یاهو، با آغوش باز از این فایلها و وبسایتها استقبال میکنند و به همین دلیل است که بینگ و یاهو، مستقل از گوگل برای خود تشکیلات رتبه بندی خاصی دارند.

به نظر میرسد نتایج جستجوی بینگ، بسیار قدیمی تر از گوگل باشند. این موضوع برای وبمستران از آن نظر حائز اهمیت است که میتوانند به قدمت محتوایی که در بینگ به ثبت میرسد پی ببرند. اما موارد چند رسانهای، همانطور که بالا گفته شد، با سرعت بیشتری ایندکس میشود. به نظر میرسد که بینگ در بروزرسانی محتوای خود در جستجو، مردد است . اما گوگل نیز مخصوصا قبل از آخرین آپدیت الگوریتم پیج رنک در سال 2013 نشان داده بود که به لینکها و صفحات شاخص و قدیمی که بینگ آنان را ایندکس میکند اهمیت میدهد.

بی اهمیتی بک لینک در بینگ:

در حالی که تمامی الگوریتمهای گوگل، برای پیدا کردن ارجاعات به صفحات و اهمیت و محبوبیت صفحه و سایت، از بک لینک بهره میبرند و این بهرهگیری تا جاییست که بسیاری حذف بک لینک را باعث سردرگمی الگوریتمهای گوگل میدانند، اینگونه لینکها در دستور کار الگوریتمهای بینگ نیست و بینگ و یاهو اهمیتی برای بک لینکها قائل نبوده و الگوریتمهای آنان نیز به دنبال بک لینک نمیرود و بیشتر معیارش را بر روی پیدا کردن وبسایتهای چند رسانهای و یا مطالب حاوی اینگونه فایلها قرار داده است.

ایندکس دامنهها:

گوگل تا زمانی که لینکهایی از تمام دامنهها عاری از اسپم و تازگی داشته باشد، آنان را به سرعت ایندکس میکند. این در حالیست که الگوریتمهای بینگ، دامنههایی مانند .edu ، .gov ، .mil ، و غیره را بسیار بهتر و در اولیت قرار میدهند. علت این امر مشخص نیست اما بررسیها نشان میدهند که این دامنهها به خاطر ارزش دلاری بالاتر، نزد بینگ از اقتدار بیشتری برخوردارند و این در حالیست که این دامنهها در گوگل، هیچ فرقی با سایر دامنهها نداشته و معیار رتبه بندی، محتواییست که دامنه منتقل و معرفی میکند.

الگوریتم eye inbound بینگ، چشم سومی برای دیدن برچسبها:

این موضوع در ابتدا کمی گیجکننده به نظر میرسد که تلاش میکنم آن را ساده توضیح دهم. متون لنگر، در برچسبها برای خود پست اهمیت دارند، بینگ برچسبهای بلند را کلمه به کلمه با الگویتم eye inbound آنالیز میکند و اینگونه برچسب را بهتر میپسندد و این چیزیست که بینگ آن را متون لنگر (anchor texts) مینامد.

چگونه سایت را برای بینگ نیز سئو کنیم:

در قدم نخست، لازم است که تمامی وبمستران بدانند که بینگ، کلمات کلیدی سایت را تنها در 100 کیلوبایت اول سایت ثبت میکند. این به چه معناست؟ به این معنا که رباتهای بینگ، زمانی که به صفحهای مراجعه میکنند، تنها تا جایی پیش میروند که 100 کیلوبایت باشد و در صورتی که صفحه بیشتر از 100 کیلوبایت باشد، ربات بینگ، مابقی را گزارش نمیکند. این البته نمیتواند مانعی باشد، تنها مساله این است که وبمستر بداند میتواند در بالای صفحه مزالب خود، برچسبها یا کلمات کلیدی را قرار دهد، این هم برای ربات گوگل قابل فهم تر است و برای بینگ و یاهو. برای نمونه، زمانی که فرد زندگینامه کارل مارکس را مینویسد، جمله آغازین را اینگونه آغاز نکند: مردی بزرگ و زاده لندن بود که تمامی دنیا را دچار تغییر کرد، بعد از نوشتن اثر معروف خود به نام سرمایه، نام خود را در تاریخ به ثبت رساند.. ایراد اینگونه شروعها در این است که کلمات هدف، در پاراگرافهای ابتدایی دیده نمیشود و بسیار بهتر است که اینگونه آغاز کرد: کارل مارکس، در خانوادهای فقیر به دنیا آمد… در اینجا عبارت کارل مارکس، که احتمالا عبارت کلیدی متن است در پاراگراف اول و در دید بهتر رباتها قرار دارد.

ریدایرکتهای 301 و 302:

بارها پیش آمده که یک وبسایت دارای چندین دامنه است که با ریدایرکت کردن، یک دامنه را به عنوان دامنه اصلی به موتور جستجوگر معرفی میکند. در حالی که الگوریتمهای گوگل، هر دو ریدایرکت 301 و 302 را میپذیرند، اما بینگ رسما اعلام کرده که در این موارد، تنها ریدایرکتهای 301 را مورد قبول میداند.

سابقا بیشتر متخصصین سئو، الگوریتمهای بینگ را بسیار کند و در مواردی نیز با واژه underdog (فلک زده) مخاطب قرار دادهاند. اما همانطور که بالاتر گفته شد یک وبمستر میتواند در کنار ورودی گوگل خود و انجام آنچه گوگل از او میخواهد نیم نگاهی نیز به سهم 17 درصدی بینگ و یاهو از بازار کلیک داشته باشد. در پایان مخاطبینی که قصد معرفی وبسایت خود به ابزار بینگ وبمستر تولز را دارند، میتوانند از لینک زیر اقدام کرده و مراحل ثبت سایت خود و نقشه سایت خود را در بینگ و یاهو به اتمام برسانند. مراحل ثبت نیز همانند مراحل ثبت وبسایت در ابزار گوگل وبمستر است.

http://www.bing.com/toolbox/webmaster

نکته: ما همیشه همراه شما هستیم

:: برچسبها:

تفاوت الگوریتم بینگ و گوگل,الگوریتم بینگ,ریدایرکتهای 301 و 302,الگوریتم eye inbound بینگ,ایندکس دامنهها,بی اهمیتی بک لینک در بینگ,بینگ، قدیمی تر ,

:: بازدید از این مطلب : 702

|

امتیاز مطلب : 5

|

تعداد امتیازدهندگان : 2

|

مجموع امتیاز : 2

ن : سایت سیلز

ت : دو شنبه 29 شهريور 1395

|

|

|

رازهای سئو

در این مقاله، به بررسی برترین رازهای سئو می پردازیم.

با www یا بدون www :

در تنظیمات وردپرس بخش همگانی کادر نشانی سایت وجود دارد که میتوانید در آن مشخص کنید وبسایت شما با www باز شود یا بدون www اما پرسش اینجاست که چرا این کار را انجام دهیم؟ علیرغم پیشرفت هوش مصنوعی الگوریتمهای گوگل، هنوز تشخیص آدرس با www و بدون www یک وبسایت برای الگوریتمها شناخته شده نیست و آنها را دو دامنه و آدرس جداگانه میشناسند و بخاطر اینکه duplicate content پیش نیاید، باید یکی از این دو وضعیت را انتخاب کرده و یکی از انها را بروی دیگری ریدایرکت کرد. دونوع ریدایرکت داریم: 301 و 302 در ریدایرکت 301 پاسخ سرور انتقال دائمی وبسایت به آدرس دیگر است و در ریدایرکت 302 پاسخ سرور انتقال موقتی سرور است.

حذف پلاگینهای اضافی:

وجود پلاگینهای غیر ضروری و بدوناستفاده، جدا از اینکه از منابع هاست وردپرس استفاده میکنند، سرعت وبسایت را تا حدودی کاهش میدهند. پلاگینهای اضافی و غیرضروری را حذف کنید.

بهینه سازی و سئو تصاویر:

یک تصویر سئو شده باید خاصیت ALT را داشته باشد، نام فایل (تصویر) مناسب و به زبان انگلیسی باشد، اندازه تصویر در تگ IMG مشخص شده باشد و حجم آن تا حدممکن کاهش پیدا کرده باشد. از افزونه EWWW برای کاهش حجم تصاویر خود، از افزونه Seo friendly image برای قرار دادن خاصیت ALT و از افزونه google image site map برای ایجاد نقشه سایت برای تصاویر استفاده کنید.

شناسایی و حذف لینکهای 404 یا شکسته:

زمانی که سرور در پاسخ به درخواست مرورگر کد 404 را برمیگرداند به معنای حذف و موجود نبودن فایل مورد نظر در سرور میباشد و این مسئله بسیار برای گوگل ناراحت کننده است و شاید یکی از دلایل پنالتی سایت باشد. برای شناسایی آنها از افزونه broken link chekcker استفاده کنید. این افزونه به صورت خودکار لینکهای شکسته را شناسایی و آنها را حدف بیپیوند میکند.

لینکهای داخلی:

یکی مسائل مهم در لینک سازی استفاده از تکنینک لینک سازی داخلی است، در محتوای مطالب مرتبط به آنها لینک بدهید و از کلمات کلیدی در انکرتکست آنها استفاده کنید. افزونههایی وجود دارند که برخی کلمات کلیدی را به صورت خودکار به صفحه مشخص شده لینک میدهند، استفاده از این افزونهها پیشنهاد نمیشود بهتر است خودتان مطالب مرتبط را به یکدیگر لینک کنید.

فعال سازی کش:

از کش استفاده کنید تا قالب وبسایتتان در سیستم کاربر ذخیره شده و در بازدیدهای بعدی لود سایت سریعتر باشد. برای فعال سازی کش از افزونههای W3C Total Cache و یا Wp Super Cache استفاده کنید.

بهینه سازی بانک اطلاعات:

شاید با شنیدن بهینه سازی بانک اطلاعاتی، بفکر نرمالایز کردن آنها بیفتید اما بانکهای وردپرس تا حد امکان و تا جایی که ممکن بود نرمالایز شدهاند فقط باید برخی اطلاعات اضافی که نیازی به آنها نیست را از درون بانک حذف کرد برای اینکار از افزونه WP Optimize استفاده کنید.

نکته: ما همیشه همراه شما هستیم

:: برچسبها:

سئو,هفت راز سئو,با www یا بدون www,حذف پلاگینهای اضافی,بهینه سازی و سئو تصاویر,شناسایی و حذف لینکهای 404 یا شکسته,لینکهای داخلی,فعال سازی کش,بهینه سازی بانک اطلاعات, ,

:: بازدید از این مطلب : 920

|

امتیاز مطلب : 7

|

تعداد امتیازدهندگان : 3

|

مجموع امتیاز : 3

ن : سایت سیلز

ت : دو شنبه 29 شهريور 1395

|

|

|

linkbilding

باسلام.

در نتایج جستجویمان به سایتهای اسپمی که با خرید لینک، محتوای بیارزشی را به کاربران ارایه میدادند، برمیخوردیم سایتهایی که وقتی باز میکردیم با سیل عظیمی از متون و تصاویر تبلیغاتی روبرو میشدیم که اصرار زیادی داشتند تا آنها را خریداری کنیم. (متاسفانه همچنان وجود دارند اما کمتر شدهاند.)

در آن مواقع ما مجبور بودیم از چندین وبسایت در صفحات مختلف نتایج جستجو دیدن کنیم تا به مطلب موردنظرمون برسیم و تنها چیزی که برایمان روشن بود این بود که صفحه اول نتایج بدرد ما نمیخوره. اما الان کاملا موضوع فرق کرده گوگل با الگوریتم پاندا توانست مقالات با ارزش و مفید و با الگوریتم پنگوئن توانست لینکهای طبیعی رو شناسایی کنه و سایتهای اسپمی زیادی رو پنالتی کنه تا یاد بگیرند که باید به کاربران وب مخصوصا کاربران گوگل احترام ویژهای قائل شوند.

در همین بین بازهم کسانی بودند که با زیرپا گذاشتن قوانین الگوریتمهای گوگل بازهم در صدد خرید لینک بودند تا با زحمت کم و مطالب کپی، خود را در صدر نتایج گوگل قرار دهند. دراین مقاله ما روشهایی را توصیه میکنیم که شما با لذت کامل مشغول به ساخت لینک برای وبسایتتان شوید و پروسه لینک بیلدینگ طبیعی را تا حدودی فرابگیرید.

ربات گوگل در حال خزش در وبسایتی است ناگهان به لینک سایت شما میرسد آنرا ردیابی میکند، موضوعات سایت را میسنجد، آیا دو سایت موضوعات مرتبطی دارند؟ آیا وبسایت دیگرهم بهاین وبسایت لینک داده است؟ چه کلمهای لینک شده است؟ و دهها مقایسه و عملیات دیگر که آرزوی هر وبمستری است تا آنها را بداند. گوگل زمانی که در خزش خود به لینک سایت شما میرسد و از صحت طبیعی بودن لینک اطمینان حاصل میکند به سایت شما احترام ویژهای قائل میشود زیرا سایت شما به عنوان مرجعی در مطلبی معرفی شده است پس حتما محتوای جالب و ارزشمندی دارید که وبسایتی به شما لینک میدهد.

اما حدث و گمانههای زیادی برای تشخیص لینکهای طبیعی وجود دارد، یک لینک طبیعی باید بدون دخالت شما و توسط کاربرانتان ایجاد شده باشد، جملهای کلیشهای که شاید هزاران بار از مدیران گوگل و یا مدیران وبسایتها شنیدهاید. فرض کنید شما در زمینه کشاورزی وبسایتی دارید و میخواهید مطلبی را برای علاقهمندان به کشاورزی به اشتراک گذاشته و آنها را از وجود چنین مقالهای با خبر کنید، چه باید کرد؟

در مقالات خود از کلمات کلیدی استفاده کنید.

مقاله مورد نظر را در صفحه وبسایت خود در شبکههای اجتماعی قرار دهید.نشر و انتشار آن با کاربرانی است که مقاله شما را پسندیده اند.

مقاله خود را در شبکههای انتشار لینک مانند لینکام یا لینکپد انتشار دهید.

در مقالات خود لینک داخلی ایجاد کرده و به دیگر مقالات مرتبط دیگر لینک بدهید.

مقاله خود را به صورت کتاب الکترونیکی منتشر کرده و در سایتهای دانلود رایگان کتاب نشر دهید.

پادکست ویدئویی یا صوتی اماده کرده و انتشار کنید.

راهحلهای زیادی وجود دارند باید شروع کنید تا آنها را پیدا کنید.زمانی که علاقه مندان به کشاورزی وارد سایت شما میشوند ساختار سایت شما نباید کاربرانتان را اذیت کند.

شبکههای اجتماعی در لینکسازی نقش تقریبا مهمی دارند مخصوصا شبکه اجتماعی گوگل پلاس که لینکهای دروناین شبکه به صورت فالو میباشند.

خوب، حالا بنظر شما گوگل چگونه طبیعی بودن یا نبودن یک لینک را تشخیص میدهد؟ از نظر بنده ممکن از روشهای زیر استفاده کند:

بررسی وجود لینک در تمامی صفحات، اگر قرار باشه کسی به وبسایتی لینک بدهد، عموما در یک پست به معرفی سایت و یا مقالهای میپردازد و در اخر لینک سایت را قرار میدهد اما اگر در تمامی صفحات تکرار شود شاید کمی مشکوک باشد.

مدت زمان حضور یک لینک در یک وبسایت چه مدت است؟ اگر در بازهای کوتاه مدت لینک پاک شود مشخصا این لینک خریداری شده است. (اگر در یک پست لینک وبسایت قرار گرفته شود، تا زمانی که مقاله در سایت وجود دارد، لینک نیز وجود خواهد داشت.)

آیا دریافت بک لینک تنها به بازه زمانی خاصی محدود میشود؟ برای مثال ممکن شما در هفته اول تاسیس وبسایت خود 100 لینک و در هفته دوم 10 لینک بگیرید، مسلما گوگل به این نوع لینک بیلدینگ شک میکند.

سایتهایی که به سایت شما لینک دادهاند، ایا از نظر موضوعی هیچ ارتباطی با موضوع سایت شما دارند؟

در تمامی وبسایتها با یک کلمه کلیدی به وبسایت شما لینک داده شده است؟

آیا تنها به یک صفحه لینک دادهاند؟

در آخر به شما پیشنهاد میکنم به کاربران وب احترام بگذارید و اجازه دهید آنها مقدمه پیشرفت و ارتقا یک سایت در رتبه بندی نتایج جستجو را فراهم کنند، به جای تمرکز بر روی خرید لینکهای غیراستاندارد و غیر طبیعی به فکرایجاد محتوای باکیفیت باشید.

نکته: ما همیشه همراه شما هستیم

:: برچسبها:

لینک بیلدینگ,ساخت لینک بیلدینگ,لینک بیلدینگ طبیعی,لینک بیلدینگ تضمینی,لینک بیلدینگ چیست,خرید لینک بیلدینگ ,

:: بازدید از این مطلب : 825

|

امتیاز مطلب : 10

|

تعداد امتیازدهندگان : 4

|

مجموع امتیاز : 4

ن : سایت سیلز

ت : دو شنبه 29 شهريور 1395

|

|

|

dorogh seo

باسلام.

زمانی نه چندان دور، به علت گسترش کمتر CMSها و هزینههای گران تاسیس آن، شعاری به نام هر ایرانی یک وبسایت نیز وجود نداشت و افراد خاصی با اهداف خاص و پشتوانه مالی قوی، اقدام به تاسیس وبسایت میکردند. این همان زمانی بود که سیستمهای وبلاگدهی رایگان، بازاری پررونق و پرمخاطب از کاربران ایرانی را به خود اختصاص داده بودند، تا جایی که کشور ایران نهمین کشور در زمینه استفاده از وبلاگ به شمار میرفت (بنمایه) . با ورود سیستمهای سایتساز قدرمند، با امکانات فراوان و انعطافپذیری بالا مانند وردپرس و انواع اسکریپتهای سایتساز و انجمنساز و سوشالنتوورکهایی که با چند کلیک، بهترین امکانات را در اختیار کاربر قرار میداد و از طرفی با ورود نمایندگیهای فراوان سیستمهای میزبانی، که حالا دیگر میزبانهای ارزان قیمتی برای کاربران به حساب میامدند بسیاری از کاربران اینترنت، تصمیم به کوچ کردن از وبلاگهای کم امکانات و محدود به وبسایتهایی با آزادی عمل و پرامکاناتتر گرفتند و در مدت کوتاهی کمتر از 5 سال تعداد وبسایتهای ایرانی از هزار وبسایت فعال به بیش از 15 هزار وبسایت تا سال 1391 رسید (بنمایه) تا جایی که در همین سال خبرگزاری دانشجویان ایران (ایسنا) اعلام کرد که 98 درصد سایتهای ایرانی به صورت زیپ شده (بستههای آماده نصب) است. این فرایند تا حد زیادی کار وبلاگها را کند و کم رونق تر و فضای داتکام را به حال انفجار رساند. از طرفی با انتشار کتابها و مقالات و ایدههای متنوعی درباره بیزینس و کسبدرآمد از وبسایت روند کوچ از وبلاگها به داتکام سرعت بیشتری به خود گرفت.

این فرآیند از طرفی میتوانست بسیار مفید باشد و از طرف دیگر چالشی بزرگ برای فضایی که اغلب تاسیس کنندگان وبسایت در آن فاقد علم و هدف لازم به حساب میامد. مدت زمان کمی طول کشید که هرج و مرج و سرقت محتوای آنلاین و به موازات آن نیز انواع محتوا به شکلی نامنظم در فضای وب پارسی پراکنده شود. آنچه در ابتدا به عنوان هدف مطرح بود پرکردن فضای وبسایت از محتوایی بود که به هر وسیلهای به این فضا راه یافته بود. موضوعات تازه و آنچه که در فضای اینترنت موجود نبود به این فضا وارد شد و این ورود، به شکلی هجومی و همگانی و با چنان سرعتی رخ داد که روندی به نام نظارت و مفاهیمی مانند کیفیت را به زیر گرفت.

به جرات میتوان گفت که تا کمتر از 5 سال گذشته کمتر کسی بود که با مفهومی به نام Search engine optimization (سئو) آشنایی داشته باشد. مقولهای که 25 سال پیش و فقط 1 سال بعد از تاسیس کمپانی گوگل (بنمایه) در سال 1999 به عنوان یک پارادایم معرفی شده بود (بنمایه) و در ابتدا نیز منحصرا در اختیار وبمستران آمریکایی بود که کمتر کسی در ایران با شبکه اینترنتی دایالآپ، حتی در سطوح ابتدایی آن علمی به نام سئو را میشناختند. چنانچه این علم حتی امروز نیز به درستی شناخته نشده است. اغلب شرکتهای طراحی که تعدادشان در کل ایران کمتر از تعداد انگشتان دست بود نیز صرفا اصول خود را بر مبنای مواردی چون امنیت، دیزاین، امکانات مورد نیاز مشتری و هماهنگی آن با کسب و کار افراد قرار داده بودند و با شروع دوره کوچ از وبلاگها به وبسایتها نیز همین اصول به عنوان مبانی تاسیس وبسایت در دستور کار قرار میگرفت.

در سال 2001 تا 2002 بود که وبمستران ایرانی با ورود تدریجی سرویسهای پرسرعت اینترنت و همزمان با تصمیم گوگل در سال 2000 تا 2001 و تاسیس مقولهای به نام پیج رنک و رتبه بندی نیز متوجه موضوعی شدند که آنان را به چالشی بزرگ میکشید. این موضوع در ابتدا مانند چکشی محکم بر سر وب پارسی فرود آمد و اغلب کوچ کنندگان متوجه موضوعی شدند با این عنوان که: اینها چیست؟ بهینه سازی چیست؟ رتبه بندی چیست؟ اصول چیست؟ پارادایم و الگوریتم چیست؟ و در پاسخ به خود گفتند که: گویی به این راحتی نیز نبود.

بازار جدیدی در وب پارسی از سال 2001 به بعد و همزمان با ورود پیج رنک و نقش سئو در آن، شکل گرفت به نام بازار سئو. نام بازار را بر آن میگذاریم به این علت در ابتدا اینگونه خدمات با هزینههای بالایی با هدف برند سازی، از جانب افراد زیادی ارایه شد که فضای آشفته آن نیز، هر بینندهای را به یاد روزهای اول هجوم کاربران از وبلاگها به وبسایتها میانداخت. حالا دیگر روند کوچ کردن، هزینه مضاعفی داشت، هزینهای که میباست به یک متخصص سئو پرداخت شود تا سئو انجام شود. این هزینه در سال 2005 در ایران بسیار متفاوت بود و کاری که افراد میکردند، معرفی سایت به موتورهای جستجوگر و نصیحتهایی به مدیران، درباره ترک عادات زشتی مانند سرقت محتوا از سایرین بود که اصطلاحا سئو نامیده میشد که سئویی مخصوص فضای وب ایران بود.

در مدت زمان کوتاهی سئوی واقعی در ایران به سئوی سیاه تبدیل شد. سئو کاران به علت عدم آگاهی و عدم علم لازم جهت تجزیه و تحلیل اصول این علم به دنبال کشف راههایی جهت دورزدن این مقوله برآمده و اغلب نیز آن را به جای یک علم، به عنوان یک محدودیت معرفی میکردند. محدودیتی که میتوان آن را دور زد و همچنان به سبک قدیم، به فعالیت ادامه داد. عقایدی که این سئوکاران سیاه به فضا و افکار وب پارسی وارد کردند، در طول زمان دست به دست چرخیده و مفهوم واقعی بهینه سازی را در زیر توصیههایی به واقع ناکارآمد، اشتباه، خلافکارانه و سیاه پنهان کرده است. افراد زیادی در طول زمان، با تلاش فراوان و کسب دانش واقعی در این زمینه سعی در جا انداختن مفاهیم درست این علم کردند که تلاشهای آنان در اغلب موارد به نتایج درخشانی نیز بدل شد. سئوی سیاه و یا سئوی ناآگاهانه، همچنان معضل فضای وب پارسی است. روشهایی اغلب ناکارآمد که نویسندگان آن صرفا با هدف پر کردن وبسایتهایشان آن را نوشته و ما را نیز بدان داشت تا در این مقاله، به تعدادی از این روشهای ناکارآمدی که شاید تا به امروز نیز به عنوان بخشی از مفاهیم سئو، به خورد دیگران داده میشد اشاره نماییم.

1. دروغی به نام الکسا

اولین دروغی که به آن خواهیم پرداخت، در زمره اولین دروغهای سئو با هدف گرفتن تبلیغات و کسب درآمد و یا فروش وبسایت، جا میگیرد. الکسا عمر بیشتری از کمپانی گوگل دارد و در سال ۱۹۹۶ تاسیس شده است (بنمایه) . محصولی از شرکت آمازون که مدعی است، سایتها را بر اساس بازدید افرادی که تولبارش را بر روی مرورگرهای خود نصب کردهاند، رتبهبندی مینماید. الکسا بر خلاف گوگل از هیچگونه الگوریتم نظارتی بر وبسایتها بهره نمیبرد و ملاک آن نیز صرفا باز شدن صفحات سایت است و این باز شدن نیز تنها در صورتی برای وبسایت امتیاز مثبت دارد که بازدید کننده تولبار الکسا را بر روی مرورگر خود نصب کرده باشد. حال با نگاهی به فضای وب پارسی میتوان به وضوح تماشا کرد که رتبهبندیهای این شرکت و ملاکهای آن و نحوه این رتبه بندی تا چه میزان شکننده و غیر قابل اعتماد است.

ذکر این نکته لازم است که در کشوری مانند کشور ما، که بیش از 99 درصد از مرورگرها و کل نرم افزارها، کرک شده هستند شاید کمتر از 20 درصد افراد باشند که برای سود رساندن به وبسایتی که از آن بازدید میکنند، به سایت الکسا رفته، تولبار آن را دانلود کرده و نصب نمایند و سپس به وبسایت مورد نظر بروند. تولبار الکسا به صورت پیش فرض بر روی تمامی مرورگرهای اورجینال نصب است و بنابراین، رتبه بندی الکسا در خارج از کشور ایران از اعتبار خوبی برخوردار است، چرا که تمامی بازدیدها به این شرکت از طریق تولبارش و مرورگرها گزارش داده میشود، اما آیا در ایران نیز تمامی کاربرانی که روزانه وبسایتها را باز میکنند و اغلب آنان نیز فرق بین مرورگر و گوگل را نمیدانند، تولبار الکسا را بر روی مرورگرهای خود نصب میکنند تا بازدیدهای خود را به اطلاع الکسا برسانند؟ این امر به واقع مضحک است. حال ببینیم که دروغی به نام الکسا، چه ارتباطی با سئو دارد؟ در نهایت میخواهیم به این نتیجه برسیم که رتبه بندی الکسا در ایران اعتباری ندارد و سئو نیز تاثیری در رتبهبندی این شرکت نداشته و جز ملاکهای آن نیست و رتبهبندی الکسا نیز ارتباطی به بالا رفتن سئو ندارد.

اغلب صاحبان وبسایتها، زمانی که رتبه وبسایت خود را در الکسا بازدید میکنند و با ارقام بالایی مواجه میشوند به سراغ سئوکاران میروند. سئو کار به آنان میگوید که بازدید وبسایت شما بسیار کم است و سایت شما بهینه نیست. در قدم اول به آنان پیشنهاد میشود که جهت بهبود رتبه در الکسا ثبت نمایند (اولین دروغ)، در دومین توصیه گفته میشود که بک لینک بخرند (دومین دروغ) در سومین توصیه گفته میشود که کدهای سایت خود و ساختار آن را تغییر دهند (سومین دروغ). در چهارمین توصیه گفته میشود که حجم وبسایت خود را کم کنند با هدف بالا بردن سرعت سایت (چهارمین دروغ) و در نهایت نیز توصیه میشود که سایت در گوگل وبمستر به ثبت برسد (پنجمین دروغ). حال در ادامه خواهیم دید که چرا اینها تماما دروغ است.

2. دروغی به نام گوگل وبمستر

گوگل وبمستر، ابزاریست که در اساس نامه گوگل نیز اجباری به استفاده از آن برای وبسایتها موجود نیست. افراد با ثبت وبسایت خود در ابزار گوگل وبمستر تنها از امکانات آن از جمله آنالیز رایگان و اطلاع از ارورهای سایت و غیره بهرهمند شده و حتی 1 درصد نیز جزئی از سئو نیست. امتیازات مثبتی برای وبمستر خواهد داشت اما آن فردی نیز که وبسایتش در این ابزار به ثبت نرسیده، چیزی را در مقوله سئو از دست نداده است. افرادی گمان میکنند که گزارشات گوگل وبمستر باعث میشود که وبمستر ایرادات سایتش را دیده و آن را رفع کند و رفع این ایرادات، سئوی سایتش را بهبود ببخشد. این نیز دروغ است، چرا که ارورهای گوگل وبمستر هرگز در زمینه سئو نیست بلکه فقط ارورهاییست که اغلب نیز اشتباه است، چرا که اگر وبمستر ارورها را باز کند خواهد دید که اروری نیست. به این دلیل که عنکبوت گوگل کمتر از 1 ثانیه را در صفحات وبسایت مانده و در صورتی که باز نشود، آن را به عنوان ارور 404 گزارش میکند که با تیک آن و فیکس آن در گوگل وبمستر و درخواست بازبینی مجدد، در خزیدن بعدی عنکبوت رفع خواهد شد و ارتباطی نیز با سئو ندارد.

ابزار دیگری که گوگل وبمستر توصیه ثبت آن را میکند، نقشه سایت در این ابزار است. این نیز امکان خوبی برای بهتر دیده شدن مطالب نیست. هرگز کسی گمان نبرد که با ثبت نقشه سایتش در گوگل وبمستر، مطالبش سریعتر ایندکس میشود. این به واقع تفکری از بیخ و بن اشتباه است. علت توصیه گوگل به ثبت نقشه سایت در این ابزار صرفا اطلاع به وبمستر است برای فهم این موضوع که چند صفحه و چند تصویر از سایتش در گوگل سابمیت (معرفی) شده و چند صفحه نیز با موفقیت ایندکس (ثبت) شده است و فقط همین. عنکبوت گوگل مطالب وبسایت را از داخل خود وبسایت ایندکس کرده و نقشه سایت را در خود وبسایت پیدا میکند و به آن مراجعه مینماید. ابزار گوگل وبمستر ابزاری 100 درصد اطلاع رسانی و خبری و آنالیزگر برای وبمستران است. هر چند که بخشهایی در این ابزار دیده میشود که وبمستر میتواند پارامترهای خزیدن عنکبوتها در سایتش را تغییر دهد که دستکاری این مقادیر نیز 100 درصد به ضرر وبمستر خواهد بود.

3. حجم صحفه اصلی وبسایت (Home Page) کمتر از 300 کیلوبایت باشد

در مرجع استت کراپ، به این نکته اشاره شده است. اینکه یک وبمستر بخشهایی از صفحه اصلی وبسایت خود را معدوم کرده تا حجم آن را کم کند، به واقع امری مضحک به نظر میرسد. تمامی وبمستران میتوانند از تمامی امکاناتی که مورد نیاز آنان است در صفحه اصلی وبسایت خود استفاده نمایند و این موضوع هیچگونه تاثیری بر سئوی سایت آنان ندارد. موضوع به سرعت لود و بارگذاری صفحه برمیگردد که با اقداماتی نظیر شکستن Css و انتخاب میزبان مناسب برای سایت باید حل و فصل شود و نه با معدوم کردن وبسایت. برترین وبسایتهای ایرانی نظیر تبیان، حجم هوم پیجی بالاتر از 800 کیلوبایت دارند و بدترین وبسایتهای ایران نیز حجم هوم پیجی بسیار کمتر از این میزان و سرعت لودی مفتضحانه.

4. هر صفحهای که زودتر لود شود در نتایج بهتری از جستجو قرار میگیرد

دروغ دیگری که مدتهاست در محافل سئو مطرح میشود، این است که صفحات مطالبی که زودتر لود میشوند، در نتایج بهتری قرار خواهند گرفت. این البته برای مخاطب بسیار لذت بخشتر خواهد بود که صفحات یک وبسایت، سریع تر از وبسایت مشابه، بارگزاری شود و عنکبوت گوگل نیز ارور 404 را گزارش نکند. اما اینها هیچ دلیل منطقی در رتبه بندی آن صفحه محسوب نمیشود. میتواند به وبسایت آسیب وارد کند اما این آسیب را به کل وبسایت خواهد زد و در صورتی که آن مطلب، فاکتورهای مورد نظر از جمله تازگی و ایجاد هدر قوی برای موتورهای جستجو را داشته باشد، حجم بارگزاری آن نمیتواند تاثیری در رتبهبندی آن مطلب داشته باشد و این مورد نیز نه با توصیههایی از جمله تقسیم مطالب طولانی به صفحات مختلف، بلکه بازمیگردد به همان موضوع تکنیکهای افزایش سرعت سایت و استفاده از میزبانهای پرسرعت و با کیفیت.

5. ما در کوتاهترین زمان، تضمین میدهیم

ما تضمین میدهیم، عبارت مضحکی در سئو است. هیچ چیزی در فضای اینترنت، نه امنیت، نه سئو، نه جایگاه، نه درآمد ثابت و نه هیچ چیز دیگری تضمینی ندارد و آن هم در کوتاه مدت. یک سئوی خوب نیز نیازمند گذر زمان است. زمانی از 6 ماه تا 1 سال. افرادی که 1 شبه سئو میکنند و 1 شبه کار میکنند، 1 شبه نیز سقوط خواهند کرد.

6. سایت را در دایرکتوریها ثبت کنید

دروغی دیگر در سئو. استتکراپ برای اولین بار، سایتهایی را که در دایرکتوریهایی نظیر یاهو و دیماز به ثبت نرسیده بودند را توصیه میکرد که وبسایت خود را ثبت کنند و آنان که ثبت نبودند، رقم سئوی سایتشان چند شماره پایین میامد (اکنون نیز چنین است). اما آیا سئو به اعداد و ارقام است و یا به نتیجه جستجوی یک لینک در موتور جستجوگر؟ گوگل اعلام کرده که از دایرکتوری دیماز استفاده میکند اما هرگز اعلامی مبنی بر اینکه ثبت وبسایت در دیماز را در معیارهای سئوی خود قرارداده چیزی اعلام نکرده است. دایرکتوری یاهو نیز که وبسایتهای ایرانی را ثبت نمیکند. دیماز نیز به سختی و آن هم بیتاثیر بر سئو.

7. هر وبسایتی که رتبه بالاتری دارد، سئوی بهتری دارد

دروغ بزرگ دیگری که در محافل سئو رایج است، به این موضوع اختصاص دارد. در مورد اول، بالاتر تشریح شد که چرا رتبه بندی الکسا در ایران اعتباری ندارد گوگل نیز، که در سال 2001 پارادایم پیج رنک را ارایه داده بود، در چند روز مانده به ژانویه 2005، در اعلانی رسمی توسط جان مولر (جانشین مت کاتز در بخش ضد اسپم گوگل) در Google Help از گوگل وبمستر، رسما اعلام کرد که این الگوریتم دیگر به روز نخواهد شد. کدام رتبه بندی؟ آیا رتبه بندی الکسا را با خرید 1 میلیون بازدیدکننده از سایتهای پاپ آپ نمیتوان 3 رقمی یا دو رقمی کرد؟ به واقع که بسیار راحت میتوان این رتبه بندی را حتی در سایتهایی که 100 درصد محتوای آنان نیز سرقتی و کپی برداری شده است اعمال کرد، چرا که الکسا فقط 1 معیار دارد و آن هم باز شدن صفحه و مدت زمان حضور کاربر در سایت است و این موضوع را که فضای رقابتی امروز به جنگ سرمایه تبدیل شده است، سابقا در مطلبی با عنوان سقوط مبهم وبسایتها، توضیح داده بودم.

به نظر میرسد که دروغهای سئو، همچنان خریدارانی داشته باشد. در اینجا نه قصد بر پا کردن آشوب را داشتیم و نه قصد درسدادن و تدریس مواردی به مخاطبین. هدف این مقاله صرفا بیان و تشریح 7 مورد از مواردی بود که هیچگونه ارتباطی با سئو و بهینه سازی ندارند. به نظر میرسد سئو را میتوان تنها و تنها در چهار مورد زیر خلاصه کرد. مواردی بسیار ساده و قابل قبول برای هر نهادی که رتبه بندی میکند و هر نهادی که امتیاز میدهد و هر معیاری که سئو را تعریف میکند:

1 . تولید محتوای اختصاصی

2 . اشتراک گذاری مطالب جدید از وبسایت به تمام شبکههای اجتماعی (نه با هدفی که دروغهای سئو عنوان میکند که برای جلب بازدید کننده، بلکه با هدف در معرض دید قرار گرفتن نوشته برای روباتهایی که در شبکههای اجتماعی بسیار فعالانهتر عمل میکنند)

3 . انتخاب هاست مناسب برای وبسایت و استفاده از میزبانهای با کیفیت و پرسرعت

4 . مطالعه و پیادهسازی تکنیکهای افزایش سرعت در وبسایت و کانفیگ کردن مواردی در وبسایت که نیاز به دخالت انسانی دارند (مانند خردکردن فایلها، کش کردن، قالب مناسب با کدنویسی صحیح و…)

نکته: ما همیشه همراه شما هستیم

:: برچسبها:

دروغ های سئو,الکسا,گوگل وبمستر,سرعت لود سایت,سئو کلاه سیاه,کلاهبرداران سئو,سئو تضمینی,ثبت در دایرکتوری ها,تولید محتوا اختصاصی,هاست مناسب ,

:: بازدید از این مطلب : 733

|

امتیاز مطلب : 18

|

تعداد امتیازدهندگان : 5

|

مجموع امتیاز : 5

ن : سایت سیلز

ت : دو شنبه 29 شهريور 1395

|

|

|

|

|

|

|